Co to jest twierdzenie Bayesa?

Twierdzenie Bayesa to przepis, który pokazuje, jak odświeżyć prawdopodobieństwa teorii po otrzymaniu dowodu. Wynika to zasadniczo z maksymalnego prawdopodobieństwa warunkowego, jednak można je wykorzystać do odpowiedniego uzasadnienia szerokiego zakresu zagadnień, w tym odświeżenia przekonań.

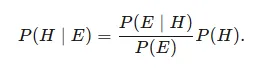

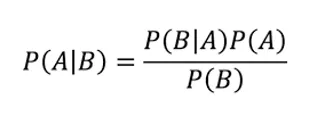

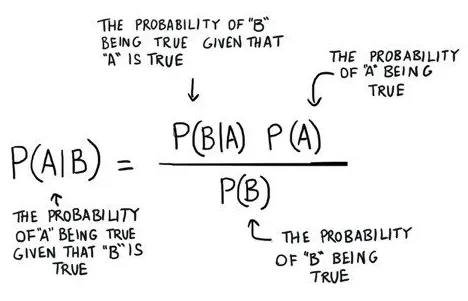

Biorąc pod uwagę teorię H i dowód E, twierdzenie Bayesa wyraża, że związek między prawdopodobieństwem spekulacji przed uzyskaniem dowodu P (H) a prawdopodobieństwem teorii po uzyskaniu dowodu P (H∣E) jest

To piękna koncepcja prawdopodobieństwa, w której znajdujemy prawdopodobieństwo, gdy znamy inne prawdopodobieństwo

Co mówi nam: jak regularnie zdarza się A, biorąc pod uwagę, że B występuje, składa się z P (A | B),

Kiedy wiemy: jak regularnie zdarza się B, biorąc pod uwagę, że występuje An, skomponowane P (B | A)

ponadto, jak prawdopodobne jest An bez nikogo innego, skomponowane P (A)

co więcej, jak prawdopodobne jest B bez nikogo innego, skomponowane P (B)

Przykład twierdzenia Bayesa

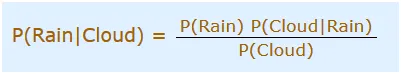

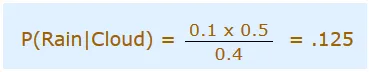

Umawiasz się dziś na wycieczkę, jednak rano jest pochmurno, Bóg nam pomaga! połowa każdego burzliwego dnia zaczyna się w cieniu! W każdym razie zacienione poranki są normalne (około 40% dni zaczyna się w pochmurne dni). Co więcej, jest to zazwyczaj suchy miesiąc (tylko 3 z 30 dni będzie ogólnie burzowych, lub 10%). Jakie jest prawdopodobieństwo ulewy w ciągu dnia? Użyjemy Deszczu, by wyrazić ulewę w ciągu dnia, a Chmurę, by wyrazić pochmurny poranek. Możliwość wystąpienia deszczu w chmurze składa się z P (deszcz | chmura)

Powinniśmy więc umieścić to w równaniu:

- P (Deszcz) Prawdopodobieństwo, że będzie Deszcz = 10% (Biorąc pod uwagę)

- P (Chmura | Deszcz) Prawdopodobieństwo, że są chmury i zdarza się deszcz = 50%

- P (Chmura) oznacza prawdopodobieństwo, że Chmury tam są = 40%

Możemy więc powiedzieć, że w c:

To jest twierdzenie Bayesa: że można wykorzystać prawdopodobieństwo jednej rzeczy, aby przewidzieć prawdopodobieństwo czegoś innego. Twierdzenie Bayesa nie jest jednak niczym statycznym. Jest to maszyna, którą kluczujesz, aby poprawić i poprawić prognozy jako nowe powierzchnie próbne. Intrygującą czynnością jest wiercenie czynników przez przeniesienie wyróżniających się właściwości teoretycznych do P (B) lub P (A) i rozważenie ich spójnego wpływu na P (A | B). Na przykład, jeśli zwiększysz mianownik P (B) po prawej stronie, wówczas P (A | B) spada. Model pełny: Katar jest oznaką odry, ale katar jest niezaprzeczalnie bardziej typowy niż wysypka skórna z małymi białymi plamami. Oznacza to, że w przypadku wybrania P (B), gdzie B jest katar, w tym momencie nawrót katarów u ogółu społeczeństwa zmniejsza prawdopodobieństwo, że katar jest oznaką odry. Prawdopodobieństwo wystąpienia odry maleje w odniesieniu do skutków ubocznych, które stają się stopniowo normalne; te przejawy nie są solidnymi wskazówkami. Podobnie, gdy odra staje się coraz bardziej normalna, a P (A) rośnie w liczniku po prawej stronie, P (A | B) rośnie zasadniczo, ponieważ istnieje prawdopodobieństwo, że odra zwykle nie zwraca uwagi na efekt uboczny, który: rozważasz.

Zastosowanie twierdzenia Bayesa w uczeniu maszynowym

Naiwny klasyfikator Bayesa

Naive Bayes to obliczenie charakterystyki dla zagadnień grupowania podwójnego (dwuklasowego) i wieloklasowego. System jest najmniej wymagający do zrozumienia, gdy jest przedstawiany z wykorzystaniem podwójnych lub bezpośrednich cech informacyjnych.

Nazywa się to naiwnym Bayesem lub imbecylem Bayesem w świetle faktu, że ustalanie prawdopodobieństw dla każdej teorii jest usprawnione, aby umożliwić ich policzenie. W przeciwieństwie do próby oszacowania szacunku każdej cechy P (d1, d2, d3 | h), uważa się, że są restrykcyjnie wolne z uwagi na wartość celu i określone jako P (d1 | h) * P (d2 | H, itp.

Jest to solidne przypuszczenie, które jest najdalej posunięte w prawdziwych informacjach, na przykład, że właściwości nie komunikują się. Z czasem metodologia sprawdza się szokująco dobrze w przypadku informacji, w których domniemanie to nie obowiązuje.

Portret używany przez modele Naive Bayes

Przedstawienie naiwnego algorytmu Bayesa to prawdopodobieństwo.

Zestaw z prawdopodobieństwami odkłada się na petycję o naukowo naiwny model bayesowski. Obejmuje to:

Prawdopodobieństwo klasowe: prawdopodobieństwo dla wszystkiego w zbiorze danych przygotowawczych.

Prawdopodobieństwo warunkowe: Prawdopodobieństwo warunkowe dla każdej informacji o instancji warte danego szacunku dla każdej klasy.

Weź naiwny model Bayesa z danych. Przyjmowanie naiwnego modelu bayesowskiego z informacji o przygotowaniu jest szybkie. Przygotowanie jest szybkie, biorąc pod uwagę fakt, że samotne są wartości prawdopodobieństwa dla każdej instancji klasy i należy określić wartość prawdopodobieństwa dla każdej instancji klasy, biorąc pod uwagę wyróżniające się wartości informacji (x). Systemy ulepszeń nie powinny pasować do żadnych współczynników.

Obliczanie prawdopodobieństw klas

Prawdopodobieństwo klasowe to w zasadzie powtarzalność przypadków, w których każda klasa jest izolowana przez pełną liczbę przypadków.

Na przykład w klasie równoległej prawdopodobieństwo przypadku zajmującego miejsce w klasie 1 określa się jako:

Prawdopodobieństwo (klasa = 1) = suma (klasa = 1) / (suma (klasa = 0) + suma (klasa = 1))

W najprostszym przypadku każda klasa ma prawdopodobieństwo 0, 5 lub połowy dla podwójnego problemu klasyfikacji z podobną liczbą wystąpień w każdym przypadku klasy.

Obliczanie prawdopodobieństwa warunkowego

Prawdopodobieństwa warunkowe to powtórzenie każdego szacunku cechy dla danej klasy, którą warto podzielić przez powtórzenie przykładów z tym szacunkiem klasy.

Wszystkie zastosowania twierdzenia Bayesa

W rzeczywistości istnieje wiele zastosowań twierdzenia Bayesa. Staraj się nie stresować, że nie widzisz od razu całej arytmetyki. Wystarczy poczuć, jak to działa, aby zacząć.

Bayesowska Teoria Decyzji jest mierzalnym sposobem na rozwiązanie problemu przykładowej klasyfikacji. W ramach tej hipotezy oczekuje się, że znany jest podstawowy transfer prawdopodobieństwa dla klas. W ten sposób uzyskujemy doskonały klasyfikator Bayesa, na podstawie którego co drugi klasyfikator podejmuje decyzję o wykonaniu.

Porozmawiamy o trzech podstawowych zastosowaniach Twierdzenia Bayesa:

- Klasyfikator Naive Bayesa

- Funkcje dyskryminacyjne i powierzchnie decyzyjne

- Szacowanie parametrów bayesowskich

Wniosek

Wspaniałość i intensywność twierdzenia Bayesa nigdy mnie nie zaskakują. Podstawowy pomysł, przekazany przez księdza, który przeszedł ponad 250 lat temu, ma zastosowanie w absolutnie najbardziej jednoznacznych procedurach AI.

Polecane artykuły

To jest przewodnik po twierdzeniu Bayesa. Tutaj omawiamy przykłady zastosowania twierdzenia Bayesa w uczeniu maszynowym oraz portret używany przez modele Naesa Bayesa. Możesz także zapoznać się z następującymi artykułami, aby dowiedzieć się więcej -

- Naiwny algorytm Bayesa

- Rodzaje algorytmów uczenia maszynowego

- Modele uczenia maszynowego

- Metody uczenia maszynowego