Różnica między Apache Storm a Apache Spark

Apache Storm to otwarty, skalowalny, odporny na awarie i rozproszony system obliczeniowy w czasie rzeczywistym. Apache Storm koncentruje się na przetwarzaniu strumieniowym lub przetwarzaniu zdarzeń. Apache Storm implementuje odporną na błędy metodę wykonywania obliczeń lub potokowania wielu obliczeń na zdarzeniu przepływającym do systemu. Apache Spark to błyskawiczna i oparta na klastrach technologia przetwarzania danych, zaprojektowana do szybkich obliczeń na dużą skalę przetwarzania danych. Apache Spark to silnik przetwarzania rozproszonego, ale nie ma wbudowanego menedżera zasobów klastra i rozproszonego systemu pamięci. Musisz podłączyć wybranego menedżera klastrów i system pamięci masowej.

Przedstawiamy więcej o Apache Storm vs Apache Spark:

- Apache Storm to równolegle do zadań ciągły silnik obliczeniowy. Definiuje przepływy pracy w Directed Acyclic Graphs (DAG's) zwanych topologiami. Te topologie działają do momentu zamknięcia przez użytkownika lub napotkania nieodwracalnej awarii. Apache Storm nie działa na klastrach Hadoop, ale używa Zookeepera i własnego pracownika stworów do zarządzania swoimi procesami. Apache Storm może odczytywać i zapisywać pliki na HDFS.

- Apache Storm integruje się z technologiami kolejkowania i baz danych, z których już korzystasz. Topologia Storm zużywa strumienie danych i przetwarza je w dowolnie skomplikowane sposoby, dzieląc strumienie między poszczególnymi etapami obliczeń, zależnie od potrzeb. Apache Storm opiera się na krotkach i strumieniach. Krotka jest w zasadzie tym, czym są twoje dane i jak są zorganizowane.

- Framework Apache Spark składa się z Spark Core i zestawu bibliotek. Spark Core wykonuje naszą pracę i zarządza nią, zapewniając użytkownikowi bezproblemową obsługę. Użytkownik musi przesłać zadanie do rdzenia Spark, a rdzeń Spark zajmuje się dalszym przetwarzaniem, wykonywaniem i odpowiedzią użytkownikowi. Mamy Spark Core API w różnych językach skryptowych, takich jak Scala, Python, Java i R.

- W Apache Spark użytkownik może użyć Apache Storm do transformacji nieustrukturyzowanych danych, które przepływają do pożądanego formatu. Musisz podłączyć wybranego menedżera klastrów i system pamięci masowej.

- Możesz wybrać Apache YARN lub Mesos dla menedżera klastra dla Apache Spark.

- Możesz wybrać rozproszony system plików Hadoop (HDFS), Google Cloud Storage, Amazon S3, Microsoft Azure dla menedżera zasobów dla Apache Spark.

- Apache Spark to silnik przetwarzania danych dla trybów wsadowych i strumieniowych obejmujący zapytania SQL, przetwarzanie grafów i uczenie maszynowe.

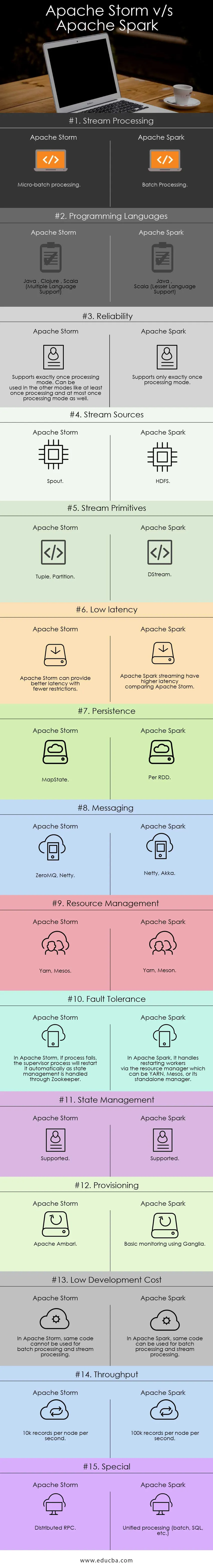

Bezpośrednie porównanie między Apache Storm a Apache Spark (infografiki):

Kluczowe różnice między Apache Storm a Apache Spark:

Poniżej znajdują się listy punktów, opisz kluczowe różnice między Apache Storm a Apache Spark:

- Apache Storm wykonuje obliczenia równoległe do zadań, podczas gdy Apache Spark wykonuje obliczenia równoległe do danych.

- Jeśli węzeł roboczy ulegnie awarii w Apache Storm, Nimbus przypisuje zadanie robocze do drugiego węzła, a wszystkie krotki wysłane do uszkodzonego węzła zostaną przekroczone i dlatego zostaną automatycznie odtworzone podczas pracy w Apache Spark, jeśli węzeł roboczy ulegnie awarii, system może ponownie wykonać obliczenia z pozostała kopia danych wejściowych i danych może zostać utracona, jeśli dane nie zostaną zreplikowane.

- Gwarancja dostarczania Apache Strom zależy od bezpiecznego źródła danych, podczas gdy w Apache Spark źródło danych HDFS jest bezpieczne.

- Apache Storm to silnik przetwarzania strumieniowego do przetwarzania danych przesyłanych strumieniowo w czasie rzeczywistym, podczas gdy Apache Spark to silnik obliczeniowy ogólnego zastosowania.

Funkcje Apache Storm:

- Odporność na awarie - w przypadku śmierci wątków roboczych lub awarii węzła pracownicy są automatycznie restartowani

- Skalowalność - wysoce skalowalny, Storm może utrzymać wydajność nawet przy rosnącym obciążeniu, dodając zasoby liniowo, gdzie można osiągnąć przepustowość nawet jednego miliona 100 bajtów wiadomości na sekundę na węzeł

- Opóźnienie - Storm wykonuje odświeżanie danych, a odpowiedź dostarczania całościowego w kilka sekund lub minut zależy od problemu. Ma bardzo małe opóźnienie.

- Łatwość użycia podczas wdrażania i obsługi systemu.

- Zintegrowany z Hadoop w celu wykorzystania wyższej wydajności

- Łatwy do wdrożenia i może być zintegrowany z dowolnym językiem programowania

- Apache Storm jest oprogramowaniem typu open source, niezawodnym i przyjaznym dla użytkownika. Może być wykorzystany zarówno w małych firmach, jak i dużych korporacjach

- Umożliwia przetwarzanie strumieniowe w czasie rzeczywistym z niewiarygodnie szybkim, ponieważ ma ogromną moc przetwarzania danych.

- Apache Storm ma inteligencję operacyjną.

- Apache Storm zapewnia gwarantowane przetwarzanie danych, nawet jeśli którykolwiek z połączonych węzłów w klastrze umrze lub wiadomości zostaną utracone

Funkcje Apache Spark:

- Szybkość: Apache Spark pomaga uruchamiać aplikację w klastrze Hadoop, do 100 razy szybszym w pamięci i 10 razy szybszym podczas uruchamiania na dysku.

- Przetwarzanie w czasie rzeczywistym: iskra Apache może obsługiwać przesyłanie strumieniowe danych w czasie rzeczywistym.

- Użyteczność : Apache Spark ma możliwość obsługi wielu języków, takich jak Java, Scala, Python i R.

- Leniwa ocena: w Apache Spark transformacje są z natury leniwe. Daje wynik po utworzeniu nowego RDD z istniejącego.

- Integracja z Hadoop: Apache Spark może działać niezależnie, a także na Hadoop YARN Cluster Manager, a zatem może odczytywać istniejące dane Hadoop.

- Odporność na awarie: Apache Spark zapewnia odporność na awarie przy użyciu koncepcji RDD. Spark RDD są zaprojektowane do obsługi awarii dowolnego węzła roboczego w klastrze.

Tabela porównawcza Apache Storm vs Apache Spark

Omawiam główne artefakty i rozróżniam Apache Storm od Apache Spark.

| Apache Storm | Apache Spark | |

| Przetwarzanie strumieniowe | Przetwarzanie mikro-partii | Przetwarzanie wsadowe |

| Języki programowania | Java, Clojure, Scala (obsługa wielu języków) | Java, Scala (obsługa mniejszego języka) |

| Niezawodność | Obsługuje dokładnie jeden tryb przetwarzania. Może być używany w innych trybach, takich jak co najmniej raz przetwarzanie, a co najwyżej raz także tryb przetwarzania | Obsługuje tylko jeden raz tryb przetwarzania |

| Źródła strumieniowe | Rynna | HDFS |

| Stream Prymitywy | Tuple, partycja | DStream |

| Małe opóźnienia | Apache Storm może zapewnić lepsze opóźnienie przy mniejszej liczbie ograniczeń | Strumieniowe przesyłanie Apache Spark ma większe opóźnienia w porównaniu z Apache Storm |

| Trwałość | MapState | Według RDD |

| Wiadomości | ZeroMQ, Netty | Netty, Akka |

| Zarządzanie zasobami | Przędza, Mesos | Przędza, mezon |

| Odporność na awarie | W Apache Storm, jeśli proces się nie powiedzie, proces nadzorcy uruchomi go ponownie automatycznie, gdy zarządzanie stanem jest obsługiwane przez Zookeeper | W Apache Spark obsługuje restartowanie pracowników za pomocą menedżera zasobów, którym może być YARN, Mesos lub samodzielny menedżer |

| Zarządzanie stanem | Utrzymany | Utrzymany |

| Provisioning | Apache Ambari | Podstawowe monitorowanie za pomocą Ganglia |

| Niskie koszty rozwoju | W Apache Storm tego samego kodu nie można używać do przetwarzania wsadowego i przetwarzania strumieniowego | W Apache Spark ten sam kod może być wykorzystywany do przetwarzania wsadowego i przetwarzania strumieniowego |

| Wydajność | 10 000 rekordów na węzeł na sekundę | 100 000 rekordów na węzeł na sekundę |

| Specjalny | Rozproszone RPC | Ujednolicone przetwarzanie (wsadowe, SQL itp.) |

Wniosek - Apache Storm vs Apache Spark:

Apache Storm i Apache Spark to świetne rozwiązania, które rozwiązują problemy związane z przetwarzaniem i przetwarzaniem strumieniowym. Apache Storm i Apache Spark mogą być częścią klastra Hadoop do przetwarzania danych. Apache Storm to rozwiązanie do przetwarzania strumieniowego w czasie rzeczywistym. Jednak Storm jest bardzo skomplikowany dla deweloperów do tworzenia aplikacji z powodu ograniczonych zasobów.

Apache Storm może być najczęściej używany do przetwarzania strumienia. Ale przemysł potrzebuje uogólnionego rozwiązania, które może rozwiązać wszystkie rodzaje problemów. Na przykład przetwarzanie wsadowe, przetwarzanie interaktywne przetwarzanie strumieniowe, a także przetwarzanie iteracyjne. Tak więc Apache Spark pojawia się w centrum uwagi, który jest silnikiem obliczeniowym ogólnego zastosowania. To jest powód, dla którego zapotrzebowanie na Apache Spark bardziej porównuje inne narzędzia przez specjalistów IT. Apache Spark może obsługiwać różne rodzaje problemów. Poza tym Apache Spark jest zdecydowanie zbyt łatwy dla programistów i bardzo dobrze integruje się z Hadoop. Apache Spark zapewnia elastyczność pracy w różnych językach i środowiskach.

Polecany artykuł

Jest to przewodnik po Apache Storm vs Apache Spark, ich znaczeniu, porównaniu bezpośrednim, kluczowych różnicach, tabeli porównawczej i wnioskach. Możesz także przejrzeć następujące artykuły, aby dowiedzieć się więcej -

- Iaas vs Azure Pass - różnice, które musisz znać

- Apache Hadoop vs Apache Spark | 10 najlepszych porównań, które musisz znać!

- 7 niesamowitych przewodników na temat Apache Spark (przewodnik)

- 15 najlepszych rzeczy, które musisz wiedzieć o MapReduce vs. Spark

- Hadoop vs Apache Spark - ciekawe rzeczy, które musisz wiedzieć