Wprowadzenie do pakowania i ulepszania

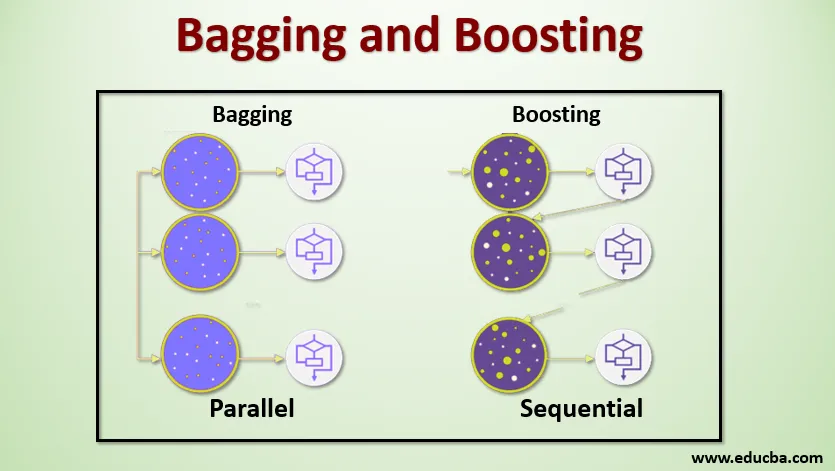

Bagging i Boosting to dwie popularne metody Ensemble. Zanim więc zrozumiemy Bagging and Boosting, zastanówmy się, czym jest nauczanie zespołowe. Jest to technika polegająca na wykorzystaniu wielu algorytmów uczenia się do trenowania modeli z tym samym zestawem danych w celu uzyskania prognozy w uczeniu maszynowym. Po uzyskaniu prognozy z każdego modelu zastosujemy techniki uśredniania modelu, takie jak średnia ważona, wariancja lub maksymalne głosowanie, aby uzyskać ostateczną prognozę. Ta metoda ma na celu uzyskanie lepszych prognoz niż indywidualny model. Powoduje to lepszą dokładność, unikając nadmiernego dopasowania, oraz zmniejsza stronniczość i współzależność. Dwie popularne metody zespołowe to:

- Bagging (agregacja bootstrapu)

- Boosting

Parcianka:

Bagging, znane również jako Agregacja Bootstrap, służy do poprawy dokładności i sprawia, że model jest bardziej uogólniony przez zmniejszenie wariancji, tj. Przez uniknięcie przeregulowania. W tym bierzemy wiele podzbiorów zestawu danych szkoleniowych. Dla każdego podzbioru bierzemy model z tymi samymi algorytmami uczenia się, jak drzewo decyzyjne, regresja logistyczna itp., Aby przewidzieć dane wyjściowe dla tego samego zestawu danych testowych. Po uzyskaniu prognozy z każdego modelu używamy techniki uśredniania modelu, aby uzyskać ostateczny wynik prognozy. Jedną ze znanych technik wykorzystywanych w Bagging jest Losowy Las . W Losowym lesie używamy wielu drzew decyzyjnych.

Zwiększenie :

Wzmocnienie stosuje się przede wszystkim w celu zmniejszenia uprzedzeń i wariancji w nadzorowanej technice uczenia się. Odnosi się do rodziny algorytmów, które przekształcają słabych uczniów (ucznia podstawowego) w silnych uczniów. Słaby uczeń jest klasyfikatorem, który jest poprawny tylko w niewielkim stopniu z faktyczną klasyfikacją, podczas gdy silny uczeń jest klasyfikatorem, który jest dobrze skorelowany z faktyczną klasyfikacją. Kilka znanych technik wzmocnienia to AdaBoost, GRADIENT BOOSTING, XgBOOST (Extreme Gradient Boosting). Teraz wiemy już, czym są bagging i boosting oraz jakie są ich role w uczeniu maszynowym.

Działanie workowania i wzmacniania

Teraz zrozumiemy, jak działa workowanie i wzmacnianie:

Parcianka

Aby zrozumieć działanie workowania, załóżmy, że mamy N modeli i zestaw danych D. Gdzie m to liczba danych, a n to liczba funkcji w każdym z danych. I mamy robić klasyfikację binarną. Najpierw podzielimy zestaw danych. Na razie podzielimy ten zestaw danych tylko na zestaw szkoleniowy i testowy. Nazwijmy zestaw danych szkoleniowych, gdzie jest łączna liczba przykładów szkoleniowych.

Pobierz próbkę rekordów z zestawu treningowego i użyj jej do wyszkolenia pierwszego modelu, powiedz m1. W kolejnym modelu m2 ponownie próbkuj zestaw treningowy i pobierz kolejną próbkę z zestawu treningowego. Zrobimy to samo dla liczby N modeli. Ponieważ ponownie próbkujemy zestaw danych szkoleniowych i pobieramy z niego próbki bez usuwania czegokolwiek z zestawu danych, możliwe, że mamy dwa lub więcej rekordów danych szkoleniowych wspólnych dla wielu próbek. Ta technika ponownego próbkowania zestawu danych szkoleniowych i dostarczania próbki do modelu jest określana jako próbkowanie w wierszu z zamiennikiem. Załóżmy, że przeszkoliliśmy każdy model, a teraz chcemy zobaczyć prognozę danych testowych. Ponieważ pracujemy nad binarną klasyfikacją, wynikiem może być 0 lub 1. Zestaw danych testowych jest przekazywany do każdego modelu i otrzymujemy prognozę z każdego modelu. Powiedzmy, że spośród N modeli więcej niż N / 2 modeli przewidywało, że będzie to 1, dlatego stosując technikę uśredniania modelu, taką jak maksymalny głos, możemy powiedzieć, że prognozowana wydajność danych testowych wynosi 1.

Boosting

W celu zwiększenia pobieramy rekordy z zestawu danych i sekwencyjnie przekazujemy je do podstawowych uczniów, tutaj podstawowymi uczniami może być dowolny model. Załóżmy, że w zestawie danych znajduje się liczba m rekordów. Następnie przekazujemy kilka rekordów do bazy BL1 i uczymy ją. Po przeszkoleniu BL1 przekazujemy wszystkie rekordy z zestawu danych i sprawdzamy, jak działa podstawowy uczeń. W przypadku wszystkich rekordów, które zostały sklasyfikowane nieprawidłowo przez podstawowego ucznia, bierzemy je i przekazujemy innym uczniowi podstawowemu, powiedzmy BL2, i jednocześnie przekazujemy nieprawidłowe rekordy sklasyfikowane przez BL2, aby trenować BL3. Będzie to obowiązywać, dopóki nie określimy określonej liczby podstawowych modeli uczniów, których potrzebujemy. Na koniec łączymy wyniki tych podstawowych uczniów i tworzymy silnego ucznia, w wyniku czego poprawia się zdolność przewidywania modelu. Dobrze. Teraz wiemy już, jak działa Bagging i Boosting.

Zalety i wady pakowania i wzmacniania

Poniżej podano najważniejsze zalety i wady.

Zalety workowania

- Największą zaletą workowania jest to, że wielu słabych uczniów może pracować lepiej niż jeden silny uczeń.

- Zapewnia stabilność i zwiększa dokładność algorytmu uczenia maszynowego stosowanego w klasyfikacji statystycznej i regresji.

- Pomaga w zmniejszeniu wariancji, tzn. Pozwala uniknąć przeuczenia.

Wady pakowania

- Może to spowodować duże odchylenie, jeśli nie zostanie odpowiednio modelowane, a zatem może prowadzić do niedopasowania.

- Ponieważ musimy używać wielu modeli, staje się on kosztownie obliczeniowy i może nie być odpowiedni w różnych przypadkach użycia.

Zalety wzmocnienia

- Jest to jedna z najbardziej skutecznych technik rozwiązywania problemów klasyfikacji dwóch klas.

- Jest dobry w obsłudze brakujących danych.

Wady wzmocnienia

- Zwiększenie wydajności jest trudne do wdrożenia w czasie rzeczywistym ze względu na zwiększoną złożoność algorytmu.

- Wysoka elastyczność tych technik skutkuje wieloma parametrami, które mają bezpośredni wpływ na zachowanie modelu.

Wniosek

Główną zaletą jest to, że Bagging and Boosting to paradygmat uczenia maszynowego, w którym używamy wielu modeli, aby rozwiązać ten sam problem i uzyskać lepszą wydajność. A jeśli odpowiednio połączymy słabych uczniów, możemy uzyskać stabilny, dokładny i solidny model. W tym artykule przedstawiłem podstawowy przegląd Bagging and Boosting. W nadchodzących artykułach poznasz różne techniki stosowane w obu. Na koniec przypomnę, że Bagging i Boosting są jednymi z najczęściej używanych technik uczenia się w zespole. Prawdziwa sztuka poprawiania wydajności polega na tym, że rozumiesz, kiedy użyć modelu i jak dostroić hiperparametry.

Polecane artykuły

Jest to przewodnik po pakowaniu i ulepszaniu. W tym miejscu omawiamy wprowadzenie do tworzenia worków i ulepszeń oraz jego działanie wraz z zaletami i wadami. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Wprowadzenie do technik ensemble

- Kategorie algorytmów uczenia maszynowego

- Algorytm zwiększania gradientu z przykładowym kodem

- Co to jest algorytm przyspieszający?

- Jak utworzyć drzewo decyzyjne?