Wprowadzenie do metod uczenia maszynowego

W poniższym artykule Metody uczenia maszynowego przedstawiono zarys najczęściej używanych metod uczenia maszynowego. Uczenie maszynowe to technika, dzięki której komputer jest w stanie „uczyć się” samodzielnie. Algorytmy adaptacyjnie poprawiają swoją wydajność wraz ze wzrostem danych dostępnych do nauki. To znaczy Im więcej danych, tym dokładniejszy byłby nasz model.

Jak uczą się maszyny?

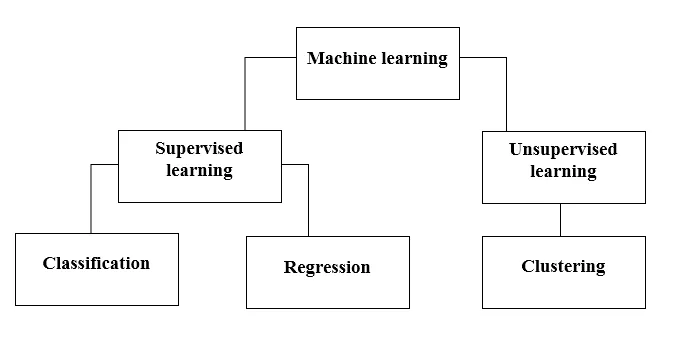

Można to zrobić na różne sposoby. Wybór metody zależy całkowicie od zgłoszenia problemu. W zależności od zestawu danych i naszego problemu istnieją dwa różne sposoby, aby przejść głębiej. Jedna to nauka nadzorowana, a druga to nauka bez nadzoru. Poniższa tabela wyjaśnia dalszą klasyfikację metod uczenia maszynowego. Omówimy je jeden po drugim.

Spójrz na poniższą tabelę!

Rozumiemy, co oznacza nadzorowane uczenie się.

Nadzorowana nauka

Jak sama nazwa wskazuje, wyobraź sobie nauczyciela lub przełożonego, którzy pomogą ci się uczyć. To samo dotyczy maszyn. Szkolimy lub uczymy maszynę na podstawie danych oznaczonych.

Niektóre z najfajniejszych nadzorowanych aplikacji edukacyjnych to:

- Analiza sentymentów (Twitter, Facebook, Netflix, YouTube itp.)

- Przetwarzanie języka naturalnego

- Klasyfikacja obrazu

- Analiza predykcyjna

- Rozpoznawanie wzorców

- Wykrywanie spamu

- Przetwarzanie mowy / sekwencji

Teraz nadzorowane uczenie się dzieli się dalej na klasyfikację i regresję. Zrozummy to.

Klasyfikacja

Klasyfikacja to proces znajdowania modelu, który pomaga rozdzielić dane na różne kategorie jakościowe. W tym procesie dane są klasyfikowane pod różnymi etykietami zgodnie z niektórymi parametrami podanymi na wejściu, a następnie etykiety są przewidywane dla danych. Kategoria oznacza, że zmienna wyjściowa jest kategorią, tj. Czerwony lub czarny, spam lub nie spam, cukrzyca lub bez cukrzycy itp.

Modele klasyfikacji obejmują maszynę wektorów nośnych (SVM), najbliższego sąsiada K (KNN), Naive Bayes itp.

a) Klasyfikator maszyn wektorów nośnych (SVM)

SVM to nadzorowana metoda uczenia się, która analizuje dane i dzieli je na jedną z dwóch kategorii. Używam hiperpłaszczyzny do kategoryzacji danych. Liniowy klasyfikator dyskryminujący próbuje narysować linię prostą oddzielającą dwa zestawy danych i tym samym stworzyć model klasyfikacji. Po prostu próbuje znaleźć linię lub krzywą (w dwóch wymiarach) lub kolektor (w wielu wymiarach), który dzieli klasy od siebie.

Uwaga - W przypadku klasyfikacji wieloklasowej SVM wykorzystuje „jeden vs odpoczynek”, co oznacza obliczanie różnych SVM dla każdej klasy.

b) Klasyfikator najbliższego sąsiada K (KNN)

- Jeśli czytasz uważnie, sama nazwa sugeruje działanie algorytmu. KNN uważa, że punkty danych, które są bliżej, są znacznie bardziej podobne pod względem cech, a zatem częściej należą do tej samej klasy co sąsiad. Dla każdego nowego punktu danych obliczana jest odległość do wszystkich innych punktów danych, a klasa jest ustalana na podstawie K najbliższych sąsiadów. Tak, może to brzmieć kiepsko, ale w przypadku niektórych klasyfikacji działa jak wszystko.

- Punkt danych jest klasyfikowany według maksymalnej liczby głosów sąsiadów, następnie punkt danych jest przypisywany do klasy najbliższej spośród jego sąsiadów.

- W KNN nie jest wymagana nauka modelu, a cała praca odbywa się w momencie, gdy wymagane jest przewidywanie. Dlatego KNN jest często nazywany leniwym algorytmem uczenia się.

c) Naiwny klasyfikator Bayesa

- Naïve Bayes to algorytm uczenia maszynowego, który jest wysoce zalecany w przypadku problemów z klasyfikacją tekstu. Opiera się na twierdzeniu prawdopodobieństwa Bayesa. Te klasyfikatory nazywane są naiwnymi, ponieważ zakładają, że zmienne cech są od siebie niezależne. Oznacza to na przykład, że mamy pełne zdanie do wprowadzenia, a następnie Naïve Bayes zakłada, że każde słowo w zdaniu jest niezależne od pozostałych. A następnie odpowiednio je sklasyfikuj. Wiem, wygląda to dość naiwnie, ale jest to świetny wybór w przypadku problemów z klasyfikacją tekstu i jest popularnym wyborem do klasyfikacji spamu.

- Zapewnia różne typy naiwnych algorytmów Bayesa, takie jak BernoulliNB, GaussianNB, MultinomialNB.

- Uważa, że wszystkie funkcje są ze sobą niezwiązane, więc nie może poznać związku między nimi. Na przykład, powiedzmy, Varun lubi jeść hamburgery, lubi też frytki z colą. Ale nie lubi jeść hamburgera i kombinacji frytek z colą. Tutaj Naïve Bayes nie może nauczyć się związku między dwiema cechami, ale uczy się jedynie znaczenia poszczególnych cech.

Przejdźmy teraz na drugą stronę naszej nadzorowanej metody uczenia się, którą jest regresja.

Regresja

Regresja to proces znajdowania modelu, który pomaga różnicować dane przy użyciu ciągłych wartości. W tym uporządkowany jest charakter przewidywanych danych. Niektóre z najczęściej stosowanych modeli regresji obejmują regresję liniową, losowy las (drzewa decyzyjne), sieci neuronowe.

Regresja liniowa

- Jedno z najprostszych podejść do nadzorowanego uczenia się, które jest przydatne w przewidywaniu odpowiedzi ilościowej.

- Regresja liniowa obejmuje znalezienie najlepiej pasującej prostej linii przez punkty. Linia najlepiej dopasowana nazywa się linią regresji. Linia najlepszego dopasowania nie dokładnie przechodzi przez wszystkie punkty danych, ale zamiast tego próbuje najlepiej się do nich zbliżyć.

- Jest to szeroko stosowany algorytm ciągłych danych. Jednak skupia się tylko na średniej zmiennej zależnej i ogranicza się do relacji liniowej.

- Regresji liniowej można użyć do szeregów czasowych, prognozowania trendów. Potrafi przewidzieć przyszłą sprzedaż na podstawie wcześniejszych danych.

Uczenie się bez nadzoru

- Uczenie się bez nadzoru opiera się na podejściu, które można uznać za nieobecność nauczyciela, a zatem bezwzględne miary błędów. Przydaje się, gdy trzeba nauczyć się grupowania lub grupowania elementów. Elementy można grupować (grupować) według ich podobieństwa.

- W uczeniu się bez nadzoru dane są nieoznaczone, nie są podzielone na kategorie, a algorytmy systemowe działają na dane bez wcześniejszego szkolenia. Algorytmy uczenia bez nadzoru mogą wykonywać bardziej złożone zadania niż algorytmy uczenia nadzorowanego.

- Uczenie się bez nadzoru obejmuje grupowanie, które można wykonać za pomocą K oznacza grupowanie, hierarchiczne, mieszanie Gaussa, ukryty model Markowa.

Aplikacje do nauki bez nadzoru to:

- Wykrywanie podobieństwa

- Automatyczne etykietowanie

- Segmentacja obiektów (np. Osoba, zwierzę, filmy)

Grupowanie

- Klastrowanie jest techniką uczenia się bez nadzoru, która jest wykorzystywana do analizy danych w wielu dziedzinach. Algorytm grupowania jest przydatny, gdy chcemy uzyskać szczegółowe informacje o naszych danych.

- Przykładem klastrowania w świecie rzeczywistym są klastry gatunków Netflix, które są podzielone dla różnych docelowych klientów, w tym zainteresowań, danych demograficznych, stylu życia itp. Teraz możesz pomyśleć o tym, jak przydatne jest tworzenie klastrów, gdy firmy chcą zrozumieć swoją bazę klientów i dotrzeć do nowego potencjału klienci.

a) K oznacza klastrowanie

- K oznacza, że algorytm klastrowania próbuje podzielić dane nieznane dane na klastry. Losowo wybiera centroid klastrów „k”, oblicza odległość między punktami danych a centroid klastrów, a następnie ostatecznie przypisuje punkt danych do centroidu klastrów, którego odległość jest minimalna dla wszystkich centroidów klastrowych.

- W k-średnich grupy są definiowane przez najbliższy centroid dla każdej grupy. Ten środek ciężkości działa jak „mózg” algorytmu, uzyskuje punkty danych, które są mu najbliższe, a następnie dodaje je do klastrów.

b) Hierarchiczne grupowanie

Klastrowanie hierarchiczne jest prawie podobne do klastrowania normalnego, chyba że chce się zbudować hierarchię klastrów. Może się to przydać, gdy chcesz zdecydować o liczbie klastrów. Załóżmy na przykład, że tworzysz grupy różnych produktów w internetowym sklepie spożywczym. Na pierwszej stronie głównej potrzebujesz kilku ogólnych elementów, a po kliknięciu jednego z elementów otwierają się określone kategorie, czyli bardziej szczegółowe klastry.

Redukcja wymiarów

Zmniejszenie wymiarów można uznać za kompresję pliku. Oznacza to usunięcie informacji, które nie są istotne. Zmniejsza złożoność danych i stara się zachować znaczące dane. Na przykład podczas kompresji obrazu zmniejszamy wymiarowość przestrzeni, w której obraz pozostaje bez zmian, nie niszcząc przy tym zbyt dużej ilości znaczących treści na obrazie.

PCA do wizualizacji danych

Analiza głównych składników (PCA) to metoda redukcji wymiarów, która może być przydatna do wizualizacji danych. PCA służy do kompresji danych o wyższych wymiarach do danych o niższych wymiarach, tzn. Możemy użyć PCA do zmniejszenia danych czterowymiarowych do trzech lub dwóch wymiarów, abyśmy mogli wizualizować i lepiej rozumieć dane.

Polecane artykuły

Jest to przewodnik po metodach uczenia maszynowego. Omówiliśmy wprowadzenie: Jak uczą się maszyny? klasyfikacje uczenia maszynowego i schemat blokowy wraz ze szczegółowym wyjaśnieniem. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Architektura uczenia maszynowego

- Ramy uczenia maszynowego

- Narzędzia do uczenia maszynowego

- Techniki uczenia maszynowego

- Uczenie maszynowe hiperparametrów

- Hierarchiczny algorytm grupowania

- Hierarchiczne grupowanie | Grupowanie aglomeracyjne i dzielące