Co to jest ekosystem Apache Hadoop?

Apache Hadoop Ecosystem to platforma lub platforma danych typu open source przeznaczona do zapisywania i sprawdzania ogromnych zbiorów danych bez struktury. Na całym świecie mnóstwo danych jest przesyłanych z wielu platform cyfrowych za pomocą wiodącej innowacyjnej technologii dużych zbiorów danych. Co więcej, Apache Hadoop był pierwszym, który otrzymał ten strumień innowacji.

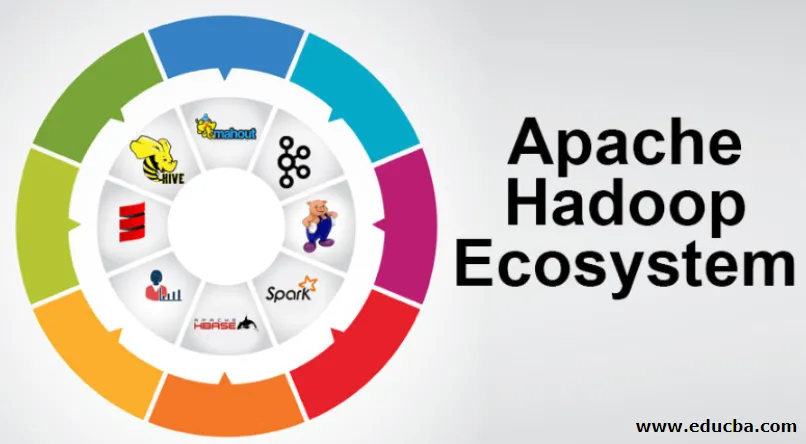

Co obejmuje architektura / ekosystem Hadoop Data?

Ekosystem Hadoop nie jest językiem programowania ani usługą, jest strukturą lub platformą zajmującą się problemami z dużymi zbiorami danych. Możesz zidentyfikować go jako pakiet obejmujący różne usługi, takie jak przechowywanie, przyjmowanie, konserwacja i analiza w nim. Następnie przeanalizuj i uzyskaj zwięzłe przemyślenie, w jaki sposób usługi działają wyłącznie i we współpracy. Architektura Apache Hadoop składa się z różnych innowacji i elementów Hadoop, dzięki którym nawet skomplikowane problemy informacyjne można skutecznie rozwiązać.

Poniżej znajduje się opis każdej części:

1) Namenode: Kieruje procesem informacyjnym

2) Datanode: Komponuje informacje do pamięci lokalnej. Zapisywanie wszystkich informacji w jednym miejscu nie jest stale zalecane, ponieważ może to spowodować utratę informacji w przypadku awarii.

3) Moduł śledzenia zadań: otrzymują obowiązki przydzielone do węzła podrzędnego

4) Mapa: Pobiera informacje ze strumienia, a każda linia jest obsługiwana podzielona na części w różnych polach

5) Zmniejsz: Tutaj pola pozyskane przez Mapę są gromadzone lub łączone ze sobą

Ekosystem Apache Hadoop - krok po kroku

Każdy element ekosystemu Hadoop, ponieważ konkretne aspekty są oczywiste. Kompleksowa perspektywa struktury Hadoop oferuje godną uwagi jakość rozproszonych systemów plików Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce i Hadoop MapReduce z ekosystemu Hadoop. Hadoop daje nawet każdą bibliotekę Java, znaczące rekordy Java, odzwierciedlenie na poziomie systemu operacyjnego, zalety i skrypty do obsługi Hadoop, Hadoop YARN to metoda opisywania biznesu i zarządzania zasobami grupowymi. W konfiguracji Hadoop HDFS zapewnia wysoki przepływ informacji do aplikacji, a Hadoop MapReduce zapewnia oparte na YARN równoległe przygotowywanie obszernego asortymentu danych.

Omówienie ekosystemu Apache Hadoop

Jest to podstawowa kwestia do zrozumienia przed rozpoczęciem pracy z ekosystemem Hadoop. Poniżej znajdują się niezbędne elementy:

- HDFS: Jest to centralna część ekosystemu Hadoop i może zaoszczędzić ogromną ilość nieustrukturyzowanych, ustrukturyzowanych i częściowo ustrukturyzowanych informacji.

- PRZĘDZA: Przypomina ekosystem Hadoop, a cała obsługa odbywa się bezpośrednio tutaj, co może obejmować alokację aktywów, planowanie zadań i przygotowywanie działań.

- MapReduce: Jest to połączenie dwóch procesów, opisanych jako Map and Reduce, i składa się z części przygotowujących esencje, które składają się na ogromne zbiory informacyjne wykorzystujące równoległe i rozproszone algorytmy w ekosystemie Hadoop.

- Apache Pig: Jest to język procedury, który jest wykorzystywany w aplikacjach obsługujących równolegle przetwarzanie dużych zbiorów informacji w stanie Hadoop, a ten język jest opcją dla programowania Java.

- HBase: jest to baza danych typu open source i niepowiązana lub baza danych NoSQL. Wzmacnia wszystkie typy informacji, dzięki czemu może radzić sobie z każdym typem informacji w ramach platformy Hadoop.

- Mahout, Spark MLib: Mahout jest wykorzystywany do uczenia maszynowego i nadaje charakter tworzeniu aplikacji do uczenia maszynowego.

- Zookeeper: Aby poradzić sobie z grupami, można wykorzystać Zookeeper, inaczej nazywany jest panem koordynacji, który może zapewnić niezawodne, szybkie i uporządkowane administracje operacyjne dla grup Hadoop.

- Oozie: Apache Oozie obsługuje planowanie pracy i działa jako usługa alertów i zegara w ekosystemie Hadoop.

- Ambari: Jest to przedsięwzięcie Apache Software Foundation i może on stopniowo realizować ekosystem Hadoop.

PRZĘDZA Hadoop:

Pomyśl o YARN jako umyśle swojego ekosystemu Hadoop. Odgrywa całość operacji przetwarzania, przydzielając zasoby i obowiązki związane z planowaniem.

Ma dwa godne uwagi segmenty, którymi są ResourceManager i NodeManager.

- ResourceManager: - Jest to ponownie główny węzeł w dziale operacyjnym. Otrzymuje przygotowywanie zapytań, a następnie przekazuje je odpowiednio do powiązanych menedżerów NodeManager, w których odbywa się prawdziwa obsługa.

- NodeManagers: - Są one instalowane na każdym DataNode. Odpowiada za wykonanie zadania na każdym węźle danych.

Jak działa apache Hadoop?

- Jego celem jest przejście z pojedynczych serwerów na ogromną liczbę komputerów, z których każdy zapewnia lokalne obliczenia i pojemność. Zamiast polegać na sprzęcie zapewniającym wysoką dostępność, sama biblioteka ma za zadanie rozróżniać i radzić sobie z rozczarowaniami w warstwie aplikacji, zapewniając w ten sposób niezwykle dostępną usługę na wielu komputerach, z których każdy może być skłonny do rozczarowań.

- Spójrz jednak dalej, a w pracy znacznie wzrasta urok. Hadoop jest całkowicie modułowy, co oznacza, że możesz zamienić praktycznie dowolny jego segment na alternatywne narzędzie programowe. To sprawia, że architektura fantastycznie się dostosowuje, jest równie wydajna i skuteczna.

Apache Hadoop Spark:

- Apache Spark to system do analizy informacji w czasie rzeczywistym w środowisku przetwarzania rozproszonego. Implementuje obliczenia w pamięci, aby zwiększyć szybkość przetwarzania informacji.

- Jest szybszy w przetwarzaniu informacji na dużą skalę, ponieważ wykorzystuje obliczenia w pamięci i różne ulepszenia. Wzdłuż tych linii wymaga dużej siły przetwarzania.

Jak działa świnia Apache?

- Apache Pig to korzystny system, który Yahoo opracowano w celu skutecznego i płynnego sprawdzania ogromnych pozycji informacyjnych. Daje trochę języka strumienia informacji najwyższego poziomu Pig Latin, który jest ulepszony, rozszerzalny i prosty w użyciu.

- Wyjątkowy komponent programów Pig, w których ich skład jest dostępny do znacznej równoległości, dzięki czemu można łatwo zająć się znacznymi zbiorami informacji.

Przypadek użycia świni:

- Prywatne informacje medyczne dotyczące danej osoby są prywatne i nie powinny być ujawniane innym osobom. Dane te należy ukryć, aby zachować poufność, jednak informacje o usługach medycznych są ogromne do tego stopnia, że rozpoznawanie i wykluczanie indywidualnych informacji na temat opieki zdrowotnej jest niezbędne. W takich warunkach można używać świni Apache do usuwania danych dotyczących zdrowia.

Wniosek:

- Został nakreślony, aby wznieść się z jednego serwera do ogromnej liczby maszyn, z których wszystkie zapewniają obliczenia i pojemność w pobliżu. Patrz jednak dalej, a praca jest coraz bardziej zaklęta.

- Hadoop jest całkowicie modułowy, co oznacza, że możesz zamienić praktycznie dowolną jego część na alternatywne narzędzie programowe. To sprawia, że struktura fantastycznie się dostosowuje, jest równie mocna i skuteczna.

Polecane artykuły

Jest to przewodnik po ekosystemie Apache Hadoop. Tutaj omówiliśmy, czym jest ekosystem Apache Hadoop? przegląd architektury Hadoop i działania ekosystemu Hadoop. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Komponenty ekosystemu Hadoop

- Jak zainstalować Apache

- Szkolenie Apache Spark

- Kariera w Hadoop