Wprowadzenie do wstępnego przetwarzania danych w uczeniu maszynowym

Wstępne przetwarzanie danych w uczeniu maszynowym jest sposobem na konwersję danych z formy surowej do postaci znacznie bardziej sformatowanej, bezużytecznej lub pożądanej. Jest to integralne zadanie uczenia maszynowego wykonywane przez naukowca danych. Ponieważ zebrane dane są w formacie surowym, może nie być możliwe wyszkolenie modelu przy jego użyciu. Ważne jest, aby dokładnie przetwarzać te surowe dane, aby dokonać właściwej interpretacji i ostatecznie uniknąć negatywnego wyniku w prognozowaniu. Krótko mówiąc, jakość naszego algorytmu uczenia się w dużej mierze zależy od typu zestawu danych, którego użyliśmy do zasilania modelu, dlatego wstępne przetwarzanie danych jest wykorzystywane do utrzymania tej jakości.

Dane zebrane w celu szkolenia modelu pochodzą z różnych źródeł. Te zebrane dane są na ogół w swoim surowym formacie, tzn. Mogą mieć odgłosy, takie jak brakujące wartości, odpowiednie informacje, liczby w formacie ciągu itp. Lub mogą być nieustrukturyzowane. Wstępne przetwarzanie danych zwiększa wydajność i dokładność modeli uczenia maszynowego. Pomaga to w usuwaniu tych dźwięków i zestawu danych oraz nadaje znaczenie zestawowi danych

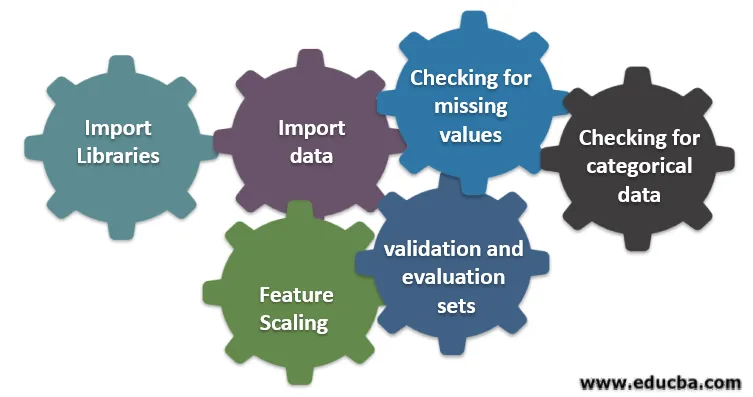

Sześć różnych kroków związanych z uczeniem maszynowym

Poniżej przedstawiono sześć różnych etapów uczenia maszynowego w celu wstępnego przetwarzania danych:

Krok 1: Zaimportuj biblioteki

Krok 2: zaimportuj dane

Krok 3: Sprawdzanie brakujących wartości

Krok 4: Sprawdzanie danych kategorycznych

Krok 5: Skalowanie funkcji

Krok 6: Podział danych na zestawy szkoleniowe, walidacyjne i ewaluacyjne

Przyjrzyjmy się szczegółowo każdemu z tych kroków:

1. Importuj biblioteki

Pierwszym krokiem jest zaimportowanie kilku ważnych bibliotek wymaganych przy przetwarzaniu danych. Biblioteka to zbiór modułów, które można wywoływać i używać. W Pythonie mamy wiele bibliotek, które są pomocne w przetwarzaniu danych.

Kilka z następujących ważnych bibliotek w Pythonie to:

- Numpy: głównie wykorzystywał bibliotekę do implementacji lub stosowania skomplikowanych obliczeń matematycznych uczenia maszynowego. Jest to przydatne podczas wykonywania operacji na tablicach wielowymiarowych.

- Pandy : Jest to biblioteka typu open source, która zapewnia wysoką wydajność oraz łatwą w użyciu strukturę danych i narzędzia analizy danych w języku python. Jest zaprojektowany w taki sposób, aby praca z relacjami i danymi oznaczonymi była łatwa i intuicyjna.

- Matplotlib: Jest to biblioteka wizualizacji dostarczona przez python dla wykresów 2D lub tablicy. Jest zbudowany na tablicy numpy i zaprojektowany do pracy z szerszym stosem Scipy. Wizualizacja zestawów danych jest pomocna w scenariuszu, w którym dostępne są duże dane. Wykresy dostępne w bibliotece Matplot to linia, słupek, rozproszenie, histogram itp.

- Seaborn: Jest to również biblioteka wizualizacji podana przez python. Zapewnia interfejs wysokiego poziomu do rysowania atrakcyjnych i informacyjnych wykresów statystycznych.

2. Importuj zestaw danych

Po zaimportowaniu bibliotek naszym następnym krokiem jest załadowanie zgromadzonych danych. Biblioteka Pandas służy do importowania tych zestawów danych. Przeważnie zestawy danych są dostępne w formatach CSV, ponieważ mają niewielkie rozmiary, co sprawia, że jest szybki do przetwarzania. Tak więc, aby załadować plik csv za pomocą funkcji read_csv z biblioteki pandy. Istnieją różne inne formaty zestawu danych, które można zobaczyć

Po załadowaniu zestawu danych musimy go sprawdzić i poszukać hałasu. W tym celu musimy stworzyć macierz cech X i wektor obserwacji Y w odniesieniu do X.

3. Sprawdzanie brakujących wartości

Po utworzeniu macierzy funkcji może się okazać, że brakuje pewnych wartości. Jeśli nie poradzimy sobie z tym, może to powodować problemy w czasie szkolenia.

Istnieją dwie metody obsługi brakujących wartości:

- Usunięcie całego wiersza zawierającego brakującą wartość, ale może istnieć możliwość utraty ważnych informacji. To może być dobre podejście, jeśli rozmiar zestawu danych jest duży.

- Jeśli w kolumnie numerycznej brakuje wartości, możesz ją oszacować, przyjmując średnią, medianę, tryb itp.

4. Sprawdzanie danych kategorycznych

Dane w zestawie danych muszą mieć postać liczbową, aby można było na nich wykonać obliczenia. Ponieważ modele uczenia maszynowego zawierają złożone obliczenia matematyczne, nie możemy podawać im wartości nienumerycznych. Dlatego ważne jest, aby przekonwertować wszystkie wartości tekstowe na wartości liczbowe. Klasa wyuczona LabelEncoder () służy do ukrywania tych wartości jakościowych w wartościach liczbowych.

5. Skalowanie funkcji

Wartości surowych danych są bardzo zróżnicowane i może to prowadzić do stronniczego szkolenia modelu lub może ostatecznie zwiększyć koszty obliczeniowe. Dlatego ważne jest, aby je znormalizować. Skalowanie cech jest techniką stosowaną w celu doprowadzenia wartości danych do krótszego zakresu.

Metody stosowane do skalowania funkcji to:

- Przeskalowanie (normalizacja min-maks.)

- Średnia normalizacja

- Standaryzacja (normalizacja Z-score)

- Skalowanie do długości jednostki

6. Podział danych na zestawy szkoleniowe, walidacyjne i ewaluacyjne

Na koniec musimy podzielić nasze dane na trzy różne zestawy, zestaw szkoleniowy do trenowania modelu, zestaw sprawdzający poprawność dokładności naszego modelu i wreszcie zestaw testowy do testowania wydajności naszego modelu na danych ogólnych. Przed podzieleniem zestawu danych ważne jest przetasowanie zestawu danych, aby uniknąć jakichkolwiek błędów. Idealna proporcja do podziału zestawu danych to 60:20:20, tj. 60% jako zestaw treningowy, 20% jako zestaw testowy i walidacyjny. Aby podzielić zestaw danych, użyj dwukrotnie train_test_split z sklearn.model_selection. Raz, aby podzielić zestaw danych na pociąg i zestaw walidacyjny, a następnie podzielić pozostały zestaw danych pociągu na pociąg i zestaw testowy.

Wniosek - wstępne przetwarzanie danych w uczeniu maszynowym

Przetwarzanie danych to coś, co wymaga praktyki. To nie jest prosta struktura danych, w której uczysz się i aplikujesz bezpośrednio, aby rozwiązać problem. Aby uzyskać dobrą wiedzę na temat czyszczenia zestawu danych lub wizualizacji zestawu danych, musisz pracować z różnymi zestawami danych.

Im więcej będziesz używać tych technik, tym lepiej zrozumiesz. To był ogólny pomysł, w jaki sposób przetwarzanie danych odgrywa ważną rolę w uczeniu maszynowym. Oprócz tego widzieliśmy także kroki niezbędne do wstępnego przetwarzania danych. Dlatego następnym razem przed treningiem modelu z wykorzystaniem zebranych danych należy zastosować wstępne przetwarzanie danych.

Polecane artykuły

Jest to przewodnik po wstępnym przetwarzaniu danych w uczeniu maszynowym. Tutaj omawiamy wprowadzenie, Sześć różnych kroków zaangażowanych w uczenie maszynowe. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Znaczenie sztucznej inteligencji

- Technologia IoT

- Typy danych PL / SQL

- Typy danych gałęzi

- R Typy danych