Wprowadzenie do ograniczonej maszyny Boltzmann

Ograniczona maszyna Boltzmanna jest metodą, która może automatycznie znajdować wzorce w danych poprzez rekonstrukcję naszych danych wejściowych. Geoff Hinton jest założycielem głębokiego uczenia się. RBM to powierzchowna sieć dwuwarstwowa, w której pierwsza jest widoczna, a następna ukryta. Każdy węzeł w widocznej warstwie jest połączony z każdym pojedynczym węzłem w ukrytej warstwie. Ograniczona maszyna Boltzmanna jest uważana za ograniczoną, ponieważ dwa węzły tej samej warstwy nie tworzą połączenia. RBM jest liczbowym odpowiednikiem translatora dwukierunkowego. W ścieżce do przodu RBM odbiera dane wejściowe i konwertuje je na zestaw liczb, które kodują dane wejściowe. W ścieżce wstecznej bierze to jako wynik i przetwarza ten zestaw danych wejściowych i tłumaczy je w odwrotnej kolejności, aby utworzyć dane wejściowe ze śledzeniem. Super przeszkolona sieć będzie w stanie wykonać to odwrotne przejście z wysoką wiarygodnością. W dwóch krokach waga i wartości mają bardzo ważną rolę. Pozwalają RBM na dekodowanie wzajemnych powiązań między wejściami, a także pomagają RBM zdecydować, które wartości wejściowe są najważniejsze w wykrywaniu prawidłowych wyników.

Działanie ograniczonej maszyny Boltzmann

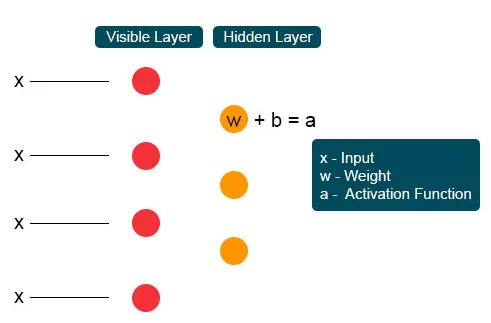

Każdy widoczny węzeł otrzymuje wartość niskiego poziomu z węzła w zbiorze danych. W pierwszym węźle niewidocznej warstwy X jest utworzony przez iloczyn masy i dodany do odchylenia. Wynik tego procesu jest podawany do aktywacji, która wytwarza moc danego sygnału wejściowego lub wyjściowego węzła.

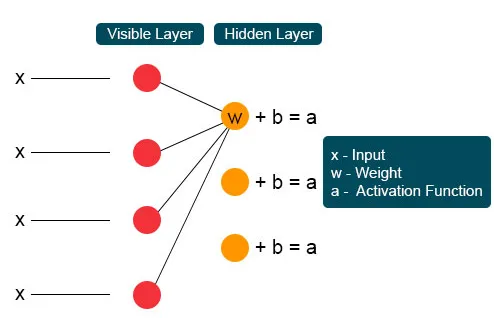

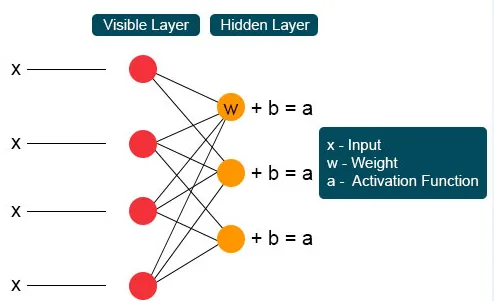

W następnym procesie kilka danych wejściowych łączyłoby się w jednym ukrytym węźle. Każdy X jest łączony przez indywidualną wagę, dodanie produktu jest przypisywane do wartości i ponownie wynik jest przekazywany przez aktywację, aby dać wynik węzła. W każdym niewidocznym węźle każde wejście X jest łączone przez indywidualną wagę W. Wejście X ma tutaj trzy ciężary, co daje dwanaście razem. Ciężar utworzony między warstwą staje się tablicą, w której wiersze są dokładne dla węzłów wejściowych, a kolumny zadowolone z węzłów wyjściowych.

Każdy niewidzialny węzeł otrzymuje cztery odpowiedzi pomnożone przez ich wagę. Dodanie tego efektu ponownie dodaje się do wartości. Działa to jako katalizator dla pewnego procesu aktywacji, a wynik jest ponownie podawany do algorytmu aktywacji, który wytwarza każde pojedyncze wyjście dla każdego niewidocznego wejścia.

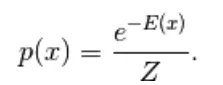

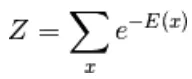

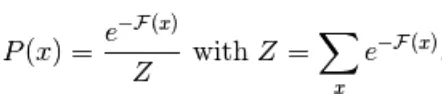

Pierwszym uzyskanym tutaj modelem jest model oparty na energii. Ten model wiąże energię skalarną z każdą konfiguracją zmiennej. Model ten określa rozkład prawdopodobieństwa poprzez funkcję energii w następujący sposób,

(1)

Tutaj Z jest czynnikiem normalizującym. Jest to funkcja partycji pod względem systemów fizycznych

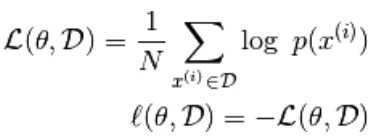

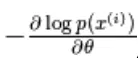

W tej funkcji opartej na energii następuje regresja logistyczna, w której pierwszy krok definiuje log-. prawdopodobieństwo, a następne zdefiniuje funkcję straty jako prawdopodobieństwo ujemne.

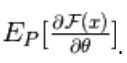

za pomocą gradientu stochastycznego,  gdzie

gdzie  są parametry,

są parametry,

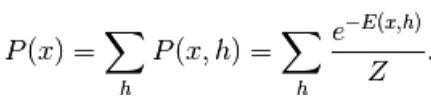

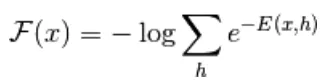

model oparty na energii z ukrytą jednostką jest zdefiniowany jako „h”

Zaobserwowana część jest oznaczona jako „x”

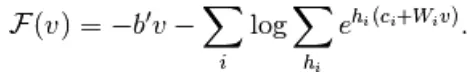

Z równania (1) równanie darmowej energii F (x) definiuje się w następujący sposób

(2)

(3)

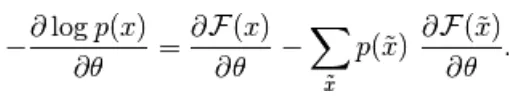

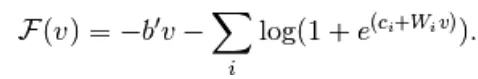

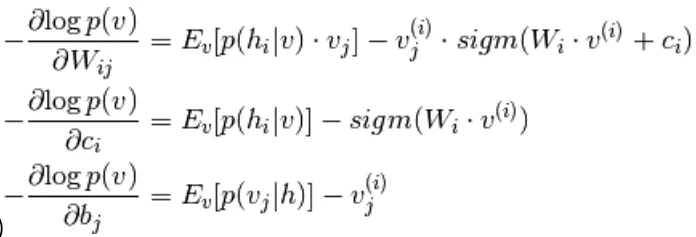

Gradient ujemny ma następującą postać:

(4)

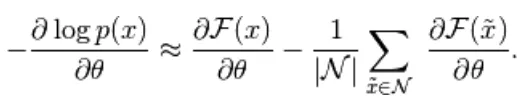

Powyższe równanie ma dwie formy, formę dodatnią i ujemną. Termin dodatni i ujemny nie jest reprezentowany przez znaki równań. Pokazują wpływ gęstości prawdopodobieństwa. Pierwsza część pokazuje prawdopodobieństwo zmniejszenia odpowiedniej energii swobodnej. Druga część pokazuje zmniejszenie prawdopodobieństwa wygenerowania próbek. Następnie gradient określa się w następujący sposób,

(5)

Tutaj N oznacza cząstki ujemne. W tym modelu opartym na energii trudno jest analitycznie zidentyfikować gradient, ponieważ obejmuje on obliczenia

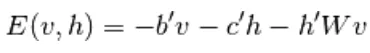

Dlatego w tym modelu EBM mamy obserwację liniową, która nie jest w stanie dokładnie przedstawić danych. Tak więc w następnym modelu Ograniczona maszyna Boltzmanna ukryta warstwa ma bardziej wysoką dokładność i zapobiega utracie danych. Funkcja energii RBM jest zdefiniowana jako:

(6)

Tutaj W oznacza wagę łączącą widoczne i ukryte warstwy. b jest przesunięciem warstwy widocznej. c jest przesunięciem warstwy ukrytej. przekształcając się w darmową energię,

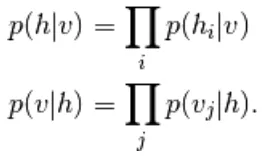

W RBM jednostki widocznej i ukrytej warstwy są całkowicie niezależne, co można zapisać w następujący sposób,

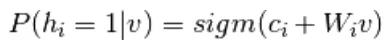

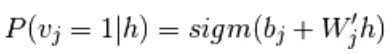

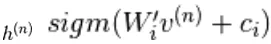

Z równania 6 i 2 wynika probabilistyczna wersja funkcji aktywacji neuronów,

(7)

(8)

Jest to jeszcze bardziej uproszczone

(9)

Łącząc równanie 5 i 9,

(10)

Pobieranie próbek w ograniczonej maszynie Boltzmanna

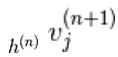

Próbkowanie Gibbsa połączenia N zmiennych losowych  odbywa się poprzez sekwencję N podetapów próbkowania formularza

odbywa się poprzez sekwencję N podetapów próbkowania formularza  gdzie

gdzie

zawiera  inne zmienne losowe w

inne zmienne losowe w  z pominięciem.

z pominięciem.

W RBM S to zestaw jednostek widocznych i ukrytych. Dwie części są niezależne i mogą wykonywać lub blokować próbkowanie Gibbsa. Tutaj jednostka widoczna wykonuje próbkowanie i podaje stałą wartość jednostkom ukrytym, jednocześnie jednostki ukryte zapewniały stałe wartości jednostce widocznej przez próbkowanie

tutaj,  jest zestawem wszystkich ukrytych jednostek.

jest zestawem wszystkich ukrytych jednostek.  Przykład

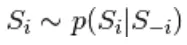

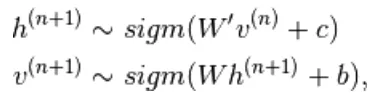

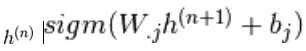

Przykład  jest losowo wybierany jako 1 (w porównaniu do 0) z prawdopodobieństwem,

jest losowo wybierany jako 1 (w porównaniu do 0) z prawdopodobieństwem,  i podobnie

i podobnie  jest losowo wybierane jako 1 (w porównaniu do 0) z prawdopodobieństwem

jest losowo wybierane jako 1 (w porównaniu do 0) z prawdopodobieństwem

Kontrastowa rozbieżność

Jest stosowany jako katalizator w celu przyspieszenia procesu pobierania próbek

Ponieważ oczekujemy, że to prawda, oczekujemy  wartość rozkładu powinna być zbliżona do P, tak aby tworzyła zbieżność z końcowym rozkładem P

wartość rozkładu powinna być zbliżona do P, tak aby tworzyła zbieżność z końcowym rozkładem P

Jednak rozbieżność kontrastowa nie czeka na zbieg łańcucha. Próbka jest pobierana dopiero po procesie Gibb, więc ustawiliśmy tutaj k = 1, gdzie działa zaskakująco dobrze.

Trwała dywergencja kontrastowa

Jest to kolejna metoda aproksymacyjnego pobierania próbek. Jest to stan trwały dla każdej metody pobierania próbek, która pobiera nowe próbki, po prostu zmieniając parametry K.

Warstwy ograniczonej maszyny Boltzmanna

Ograniczona maszyna Boltzmanna ma dwie warstwy, płytkie sieci neuronowe, które łączą się, tworząc blok sieci głębokich przekonań. Pierwsza warstwa to warstwa widoczna, a druga warstwa to warstwa ukryta. Każda jednostka odnosi się do koła podobnego do neuronu zwanego węzłem. Węzły z ukrytej warstwy są połączone z węzłami z widocznej warstwy. Ale dwa węzły tej samej warstwy nie są połączone. Tutaj termin Ograniczony odnosi się do braku komunikacji międzywarstwowej. Każdy węzeł przetwarza dane wejściowe i podejmuje stochastyczną decyzję, czy przekazać dane wejściowe, czy nie.

Przykłady

Ważną rolą RBM jest rozkład prawdopodobieństwa. Języki są unikalne pod względem liter i dźwięków. Rozkład prawdopodobieństwa litery może być wysoki lub niski. W języku angielskim powszechnie stosuje się litery T, E i A. Ale w języku islandzkim zwykłe litery to A i N. Nie możemy próbować odtworzyć języka islandzkiego z wagą opartą na języku angielskim. Doprowadzi to do rozbieżności.

Następnym przykładem są obrazy. Rozkład prawdopodobieństwa ich wartości w pikselach jest różny dla każdego rodzaju obrazu. Możemy wziąć pod uwagę, że istnieją dwa obrazy Elephant i Dog dla holowniczych węzłów wejściowych, przejście do przodu RBM wygeneruje pytanie, tak jak powinienem wygenerować silny piksel dla węzła słonia lub psa? Następnie przejście do tyłu wygeneruje pytania takie jak dla słonia, jak mam oczekiwać rozkładu pikseli? Następnie z prawdopodobieństwem i aktywacją stawu wytworzonymi przez węzły zbudują sieć ze wspólnym występowaniem stawu, jak duże uszy, szara nieliniowa rurka, dyskietki uszy, zmarszczka to słoń. Stąd RBM jest procesem głębokiego uczenia się i wizualizacji, które tworzą dwie główne tendencje i działają w oparciu o sens aktywacji i rekonstrukcji.

Zalety ograniczonej maszyny Boltzmann

- Ograniczona maszyna Boltzmanna jest stosowana algorytmem stosowanym do klasyfikacji, regresji, modelowania tematów, wspólnego filtrowania i uczenia się funkcji.

- Ograniczona maszyna Boltzmanna jest używana do neuroobrazowania, rzadkiej rekonstrukcji obrazu w planowaniu kopalni, a także w rozpoznawaniu celu radarowego

- RBM jest w stanie rozwiązać problem niezrównoważonych danych za pomocą procedury SMOTE

- RBM znajduje brakujące wartości na podstawie próbkowania Gibb, który jest stosowany do pokrycia nieznanych wartości

- RBM rozwiązuje problem głośnych etykiet dzięki nieskorygowanym danym etykiet i błędom ich rekonstrukcji

- Problem nieustrukturyzowanych danych jest usuwany przez ekstraktor funkcji, który przekształca surowe dane w ukryte jednostki.

Wniosek

Głębokie uczenie się jest bardzo potężne, co jest sztuką rozwiązywania złożonych problemów, jest wciąż miejscem na ulepszenia i jest skomplikowane do wdrożenia. Wolne zmienne należy konfigurować ostrożnie. Pomysły związane z siecią neuronową były wcześniej trudne, ale dziś głębokie uczenie się jest podstawą uczenia maszynowego i sztucznej inteligencji. Dlatego RBM daje wgląd w ogromne algorytmy głębokiego uczenia. Zajmuje się podstawową jednostką kompozycji, która stopniowo przerodziła się w wiele popularnych architektur i jest szeroko stosowana w wielu dużych branżach.

Polecany artykuł

Jest to przewodnik po ograniczonej maszynie Boltzmanna. Tutaj omawiamy jego działanie, pobieranie próbek, zalety i warstwy ograniczonej maszyny Boltzmanna. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej _

- Algorytmy uczenia maszynowego

- Architektura uczenia maszynowego

- Rodzaje uczenia maszynowego

- Narzędzia do uczenia maszynowego

- Implementacja sieci neuronowych