Wprowadzenie do poleceń Hadoop fs

W tym artykule omówimy polecenia obsługi plików HADOOP, które służą do zarządzania plikami za pośrednictwem konsoli.

Będziesz potrzebował systemu Linux i najnowszej wersji Hadoop. Aby wydrukować wersję Hadoop, aby wiedzieć, przez kogo wydanie zostało zbudowane, wartość sumy kontrolnej wystarczy wykonać poniższe polecenie po zalogowaniu się na platformie Hadoop.

Polecenie: wersja Hadoop

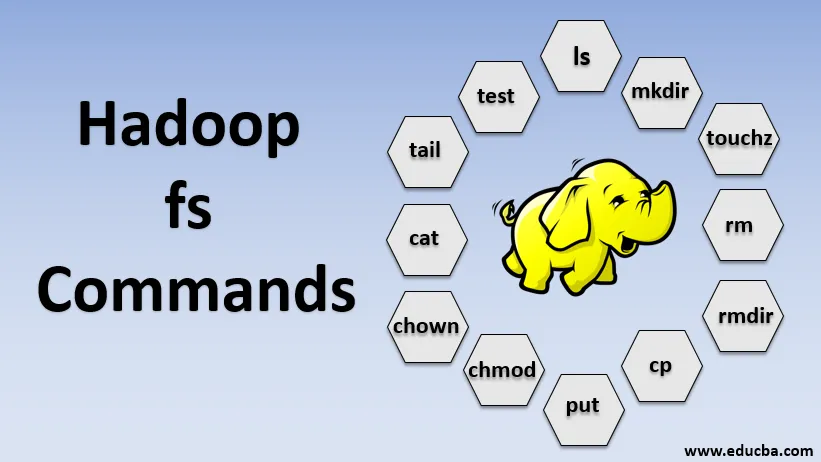

Komendy Hadoop fs

Teraz nauczmy się, jak używać komend HADOOP fs.

Zaczniemy od podstaw. Po prostu wpisz te polecenia w PUTTY lub dowolnej konsoli, z którą czujesz się wygodnie.

1. hadoop fs -ls

W przypadku katalogu zwraca listę plików i katalogów, natomiast w przypadku pliku zwraca statystyki pliku.

hadoop fs -lsr: służy do rekurencyjnego wyświetlania katalogów i plików w określonych folderach.

- Przykład : hadoop fs -ls / lub hadoop fs -lsr

- -d: Służy do wyświetlania katalogów jako zwykłych plików.

- -h: Służy do formatowania rozmiarów plików w sposób czytelny dla człowieka, a nie tylko liczbę bajtów.

- -R: Służy do rekurencyjnego wyświetlania zawartości katalogów.

2. hadoop fs -mkdir

To polecenie przyjmuje ścieżkę jako argument i tworzy katalogi w formacie hdfs.

- Przykład : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Tworzy pusty plik i nie wykorzystuje miejsca

- Przykład: hadoop fs -touchz URI

4. hadoop fs -rm

Usuń pliki określone jako argument. Musimy podać opcję -r, aby usunąć cały katalog. A jeśli podano opcję -skipTrash, pominie kosz i plik zostanie natychmiast usunięty.

- Przykład : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Usuwa pliki i uprawnienia do katalogów i podkatalogów. Zasadniczo jest to rozszerzona wersja Hadoop fs -rm.

6. hadoop fs -cp

Kopiuje plik z jednej lokalizacji do drugiej

- Przykład : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Kopiuje plik z edgenode do HDFS.

8. hadoop fs -put

Kopiuje plik z edgenode do HDFS, jest podobny do poprzedniego polecenia, ale put odczytuje również wejście ze standardowego wejścia standardowego i zapisuje do HDFS

- Przykład : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Flaga zachowuje dostęp, czas modyfikacji, własność i tryb.

hadoop fs -put -f: To polecenie zastępuje miejsce docelowe, jeśli plik już istnieje przed kopiowaniem.

9. hadoop fs -moveFromLocal

Jest podobny do kopiowania z lokalnego, z tym że plik źródłowy jest usuwany z lokalnego edgenode po skopiowaniu do HDFS

- Przykład : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Kopiuje plik z HDFS do edgenode.

- Przykład : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

To polecenie pomaga nam zmienić dostęp do pliku lub katalogu

- Przykład : hadoop fs -chmod (-R) (ścieżka)

12. hadoop fs -chown

To polecenie pomaga nam zmienić własność pliku lub katalogu

- Przykład : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Drukuje zawartość pliku HDFS na terminalu

- Przykład : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Wyświetla ostatni KB pliku HDFS na standardowe wyjście

- Przykład : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

To polecenie jest używane do operacji testowania plików HDFS, zwraca 0, jeśli jest prawdziwe.

- - e: sprawdza, czy plik istnieje.

- -z: sprawdza, czy plik ma zerową długość

- -d / -f: sprawdza, czy ścieżka to odpowiednio katalog / plik

Tutaj szczegółowo omawiamy przykład

- Przykład : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Wyświetla rozmiary plików i katalogów zawartych w danym katalogu lub długość pliku w przypadku, gdy jest to plik

17. hadoop fs -df

Wyświetla wolne miejsce

18. hadoop fs -checksum

Zwraca informacje o sumie kontrolnej pliku

19. hadoop fs -getfacl

Wyświetla listę kontroli dostępu (ACL) określonego pliku lub katalogu

20. hadoop fs -count

Liczy liczbę katalogów, plików i bajtów pod ścieżką, która odpowiada podanemu wzorowi plików.

21. hadoop fs -setrep

Zmienia współczynnik replikacji pliku. A jeśli ścieżka jest katalogiem, polecenie zmienia współczynnik replikacji wszystkich plików w tym katalogu.

- Przykład : hadoop fs -setrep -R / user / datahub: służy do akceptacji możliwości wstecznej i nie ma żadnego efektu.

hadoop fs - setrep -w / user / datahub : czeka na zakończenie replikacji

22. hadoop fs -getmerge

Łączy pliki HDFS w źródle z docelowym plikiem lokalnym

- Przykład : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Dołącza pojedyncze źródło lub wiele źródeł z lokalnego systemu plików do miejsca docelowego.

- Przykład : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Drukuje statystyki dotyczące pliku lub katalogu.

- Przykład : hadoop fs -stat (format)

Wniosek - polecenia Hadoop fs

Przeszliśmy przez prawie wszystkie polecenia niezbędne do obsługi plików i przeglądania danych w plikach. Możesz teraz modyfikować pliki i przetwarzać dane na platformie Hadoop.

Polecane artykuły

To jest przewodnik po poleceniach Hadoop fs. Tutaj omawiamy wprowadzenie do poleceń Hadoop fs wraz ze szczegółowym przykładem. Możesz także przejrzeć następujące artykuły, aby dowiedzieć się więcej-

- Zainstaluj Hadoop

- Narzędzia Hadoop

- Architektura Hadoop

- Komponenty Hadoop

- Polecenia hadoop fs