Wprowadzenie do Hadoop Framework

Zanim zagłębimy się w techniczne ramy Hadoop, zaczniemy od prostego przykładu.

Istnieje farma, która zbiera pomidory i przechowuje je w jednym miejscu, teraz przy rosnącym popycie warzyw farma zaczęła zbierać ziemniaki, marchew - przy rosnącym popycie brakowało rolników, więc zatrudniali więcej rolników. Po pewnym czasie zdali sobie sprawę, że brakuje miejsca w magazynie - więc rozprowadzili warzywa w różnych miejscach. Jeśli chodzi o pobieranie danych, wszystkie działają równolegle z własnym miejscem do przechowywania.

Jak ta historia jest powiązana z Big Data?

Wcześniej mieliśmy ograniczone dane, z ograniczonym procesorem i jedną jednostką pamięci. Ale potem generowanie danych wzrosło, prowadząc do dużej ilości i różnych odmian - ustrukturyzowanych, częściowo ustrukturyzowanych i nieustrukturyzowanych, więc rozwiązaniem było użycie rozproszonej pamięci dla każdego procesora, co umożliwiło łatwy dostęp do przechowywania i dostępu do danych.

Teraz możemy zastąpić warzywa jako różne rodzaje danych i miejsca do przechowywania jako miejsca rozproszone do przechowywania danych i różnych pracowników będących każdym procesorem.

Tak więc Big Data jest wyzwaniem, a Hadoop odgrywa rolę Rozwiązania.

HADOOP

1. Rozwiązanie dla WIELKICH DANYCH: ponieważ dotyczy złożoności dużej objętości, prędkości i różnorodności danych.

2. Zestaw projektu typu open source.

3. Niezawodnie przechowuje dużą ilość danych i umożliwia ogromne obliczenia rozproszone.

4. Kluczowymi atrybutami Hadoop są redundancja i niezawodność (absolutnie brak utraty danych).

5. Przede wszystkim koncentruje się na przetwarzaniu wsadowym.

6. Działa na sprzęcie towarowym - nie musisz kupować żadnego specjalnego drogiego sprzętu.

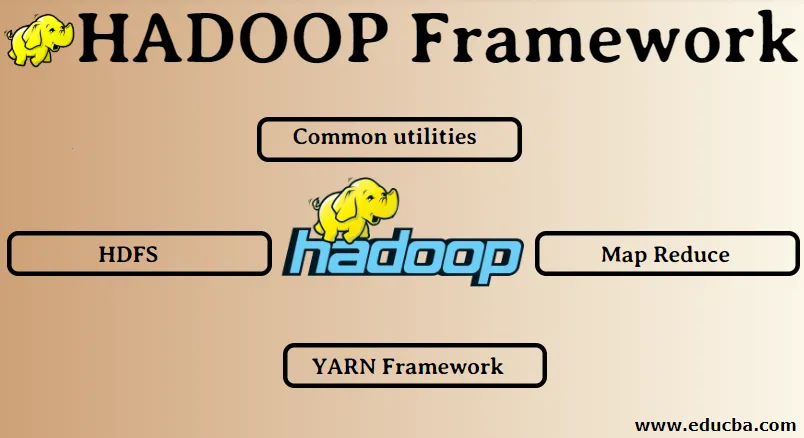

Hadoop Framework:

1. Wspólne narzędzia

2. HDFS

3. Zmniejsz mapę

4. Struktura YARN

1. Typowe narzędzia:

Nazywany również pospolitym Hadoop. Są to tylko biblioteki, pliki, skrypty i narzędzia JAVA, które są faktycznie wymagane przez inne komponenty Hadoop.

2. HDFS: Rozproszony system plików Hadoop

Dlaczego Hadoop zdecydował się wprowadzić rozproszony system plików?

Rozumiemy to na przykładzie: Musimy odczytać 1 TB danych i mamy jedną maszynę z 4 kanałami We / Wy, każdy kanał o prędkości 100 MB / s, odczytanie wszystkich danych zajęło 45 minut. Teraz ta sama ilość danych jest odczytywana przez 10 komputerów, każdy z 4 kanałami We / Wy, każdy kanał o prędkości 100 MB / s. Zgadnij, ile czasu zajęło odczytanie danych? 4, 3 minuty HDFS rozwiązuje problem przechowywania dużych zbiorów danych. Dwoma głównymi komponentami HDFS są NAZWA NODE i DATA NODE. Węzeł nazw jest nadrzędny, możemy również mieć dodatkowy węzeł nazw, na wypadek, gdyby podstawowy węzeł nazw przestał działać, dodatkowy węzeł nazw będzie działał jako kopia zapasowa. Węzeł nazwy zasadniczo utrzymuje i zarządza węzłami danych poprzez przechowywanie metadanych. Węzłem danych jest urządzenie podrzędne, które jest zasadniczo tanim sprzętem towarowym. Możemy mieć wiele węzłów danych. Węzeł danych przechowuje rzeczywiste dane. Ten węzeł danych obsługuje współczynnik replikacji, przypuśćmy, że jeśli jeden węzeł danych ulegnie awarii, wówczas dostęp do danych może uzyskać drugi replikowany węzeł danych, dlatego poprawia się dostępność danych i zapobiega się utracie danych.

3. Zmniejsz mapę:

Rozwiązuje problem przetwarzania dużych zbiorów danych. Rozumiemy pojęcie redukcji map poprzez rozwiązanie tego rzeczywistego problemu. Firma ABC chce obliczyć całkowitą sprzedaż z uwzględnieniem miasta. Teraz tutaj koncepcja tabeli skrótów nie będzie działać, ponieważ dane są w terabajtach, więc użyjemy koncepcji Map-Reduce.

Istnieją dwie fazy: a) MAPA. b) ZMNIEJSZYĆ

a) Mapa : Najpierw podzielimy dane na mniejsze części zwane programami mapującymi na podstawie pary klucz / wartość. Tutaj kluczem będzie nazwa miasta, a wartością będzie całkowita sprzedaż. Każdy twórca map otrzyma dane z każdego miesiąca, które podadzą nazwę miasta i odpowiednią sprzedaż.

b) Zmniejszenie: otrzyma te stosy danych, a każdy reduktor będzie odpowiedzialny za miasta Północ / Zachód / Wschód / Południe. Tak więc praca reduktora będzie polegała na zbieraniu tych małych kawałków i przeliczaniu ich na większe ilości (przez dodanie ich) dla określonego miasta.

4. YARN Framework: Kolejny negocjator zasobów.

Początkowa wersja Hadoop miała tylko dwa komponenty: Map Reduce i HDFS. Później okazało się, że Map Reduce nie może rozwiązać wielu problemów z dużymi danymi. Pomysł polegał na odjęciu obowiązków związanych z zarządzaniem zasobami i planowaniem zadań ze starego silnika zmniejszania mapy i przekazaniem go nowemu komponentowi. Tak oto pojawił się YARN. Jest to środkowa warstwa między HDFS a Map Reduce, która odpowiada za zarządzanie zasobami klastra.

Ma do spełnienia dwie kluczowe role: a) Planowanie zadań. b) Zarządzanie zasobami

a) Planowanie zadań: Gdy duża ilość danych jest przekazywana do przetwarzania, należy je rozdzielić i podzielić na różne zadania / zadania. Teraz JS decyduje, które zadanie powinno mieć najwyższy priorytet, odstęp czasowy między dwoma zadaniami, zależność między zadaniami, sprawdza, czy między uruchomionymi zadaniami nie nakładają się.

b) Zarządzanie zasobami: Do przetwarzania danych i przechowywania danych potrzebujemy zasobów, prawda? Menedżer zasobów zapewnia, zarządza i utrzymuje zasoby do przechowywania i przetwarzania danych.

Teraz mamy jasność na temat koncepcji Hadoop i tego, jak rozwiązuje ona wyzwania stworzone przez BIG DATA !!!

Polecane artykuły

To był przewodnik po Hadoop Framework. Tutaj omówiliśmy również 4 najlepsze frameworki Hadoop. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Baza danych Hadoop

- Ekosystem Hadoop

- Zastosowania Hadoop

- Zadania administratora Hadoop

- Administrator Hadoop | Ścieżki umiejętności i kariery