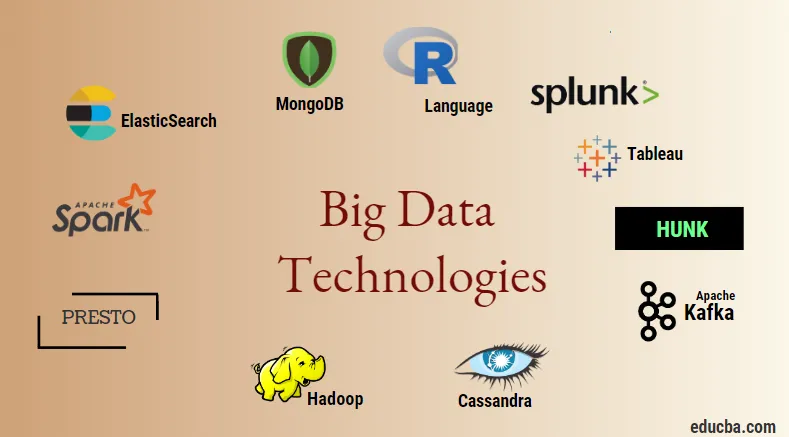

Wprowadzenie do technologii Big Data

Technologia Big Data i Hadoop to duże modne hasło, jak może się wydawać. Ponieważ nastąpił ogromny wzrost w dziedzinie danych i informacji z każdej branży i domeny, bardzo ważne jest ustanowienie i wprowadzenie wydajnej techniki, która zaspokoi wszystkie potrzeby i wymagania klientów i dużych branż odpowiedzialnych za generowanie danych . Wcześniej dane były przetwarzane przez normalne języki programowania i prosty ustrukturyzowany język zapytań, ale teraz te systemy i narzędzia nie wydają się wiele robić w przypadku dużych zbiorów danych. Technologia Big Data jest definiowana jako technologia i narzędzie programowe, które jest przeznaczone do analizy, przetwarzania i wydobywania informacji z dużego zestawu niezwykle złożonej struktury i dużych zbiorów danych, co jest bardzo trudne dla tradycyjnych systemów. Technologia Big Data jest używana do obsługi zarówno danych w czasie rzeczywistym, jak i partii. Uczenie maszynowe stało się bardzo ważnym elementem codziennego życia i każdej branży, dlatego zarządzanie danymi za pośrednictwem dużych zbiorów danych staje się bardzo ważne.

Rodzaje technologii Big Data

Zanim zaczniemy od listy technologii, najpierw zobaczmy szeroką klasyfikację wszystkich tych technologii. Można je głównie podzielić na 4 domeny.

- Przechowywanie danych

- Analityka

- Eksploracja danych

- Wyobrażanie sobie

Najpierw omówmy wszystkie technologie, które są objęte parasolem do przechowywania.

1. Hadoop : jeśli chodzi o duże zbiory danych, Hadoop jest pierwszą technologią, która wchodzi w grę. Jest to oparte na architekturze zmniejszającej mapę i pomaga w przetwarzaniu zadań związanych z wsadami i przetwarzaniu informacji o wsadach. Został zaprojektowany do przechowywania i przetwarzania danych w rozproszonym środowisku przetwarzania danych wraz ze sprzętem towarowym i prostym modelem wykonania programu. Można go używać do przechowywania i analizowania danych obecnych na różnych maszynach o dużej pojemności, szybkości i niskich kosztach. Jest to jeden z głównych składników technologii dużych zbiorów danych, która została opracowana przez fundację Apache w 2011 roku i napisana w Javie.

1. Hadoop : jeśli chodzi o duże zbiory danych, Hadoop jest pierwszą technologią, która wchodzi w grę. Jest to oparte na architekturze zmniejszającej mapę i pomaga w przetwarzaniu zadań związanych z wsadami i przetwarzaniu informacji o wsadach. Został zaprojektowany do przechowywania i przetwarzania danych w rozproszonym środowisku przetwarzania danych wraz ze sprzętem towarowym i prostym modelem wykonania programu. Można go używać do przechowywania i analizowania danych obecnych na różnych maszynach o dużej pojemności, szybkości i niskich kosztach. Jest to jeden z głównych składników technologii dużych zbiorów danych, która została opracowana przez fundację Apache w 2011 roku i napisana w Javie.

2. MongoDB : Kolejnym bardzo istotnym i kluczowym elementem technologii dużych zbiorów danych w zakresie przechowywania jest baza danych MongoDB NoSQL. Jest to baza danych NoSQL, co oznacza, że właściwości relacyjne i inne właściwości związane z RDBMS nie mają do niej zastosowania. Różni się od tradycyjnych baz danych RDBMS, które korzystają ze strukturalnego języka zapytań. Wykorzystuje dokumenty schematu, a struktura przechowywania danych jest również inna i dlatego są one pomocne w przechowywaniu dużej ilości danych. Jest to wieloplatformowy, zorientowany na dokumenty program do projektowania i baz danych, który wykorzystuje dokumenty podobne do JSON wraz ze schematem. Staje się to bardzo przydatnym przypadkiem użycia operacyjnych baz danych w większości instytucji finansowych, a tym samym działa na rzecz zastąpienia tradycyjnych komputerów mainframe. MongoDB obsługuje elastyczność, a także szeroką gamę typów danych w dużych ilościach i między architekturami rozproszonymi.

2. MongoDB : Kolejnym bardzo istotnym i kluczowym elementem technologii dużych zbiorów danych w zakresie przechowywania jest baza danych MongoDB NoSQL. Jest to baza danych NoSQL, co oznacza, że właściwości relacyjne i inne właściwości związane z RDBMS nie mają do niej zastosowania. Różni się od tradycyjnych baz danych RDBMS, które korzystają ze strukturalnego języka zapytań. Wykorzystuje dokumenty schematu, a struktura przechowywania danych jest również inna i dlatego są one pomocne w przechowywaniu dużej ilości danych. Jest to wieloplatformowy, zorientowany na dokumenty program do projektowania i baz danych, który wykorzystuje dokumenty podobne do JSON wraz ze schematem. Staje się to bardzo przydatnym przypadkiem użycia operacyjnych baz danych w większości instytucji finansowych, a tym samym działa na rzecz zastąpienia tradycyjnych komputerów mainframe. MongoDB obsługuje elastyczność, a także szeroką gamę typów danych w dużych ilościach i między architekturami rozproszonymi.

3. Przystojniak : Jest przydatny w uzyskiwaniu dostępu do danych za pośrednictwem zdalnych klastrów Hadoop poprzez wykorzystanie wirtualnych indeksów, a także wykorzystuje język przetwarzania wyszukiwania Splunk, który może być wykorzystywany do analizy danych. Przystojniak może służyć do raportowania i wizualizacji ogromnych ilości danych z baz danych i źródeł Hadoop i NoSQL. Został on opracowany przez zespół Splunk w 2013 roku, który został napisany w Javie.

3. Przystojniak : Jest przydatny w uzyskiwaniu dostępu do danych za pośrednictwem zdalnych klastrów Hadoop poprzez wykorzystanie wirtualnych indeksów, a także wykorzystuje język przetwarzania wyszukiwania Splunk, który może być wykorzystywany do analizy danych. Przystojniak może służyć do raportowania i wizualizacji ogromnych ilości danych z baz danych i źródeł Hadoop i NoSQL. Został on opracowany przez zespół Splunk w 2013 roku, który został napisany w Javie.

4. Cassandra : Cassandra stanowi najlepszy wybór spośród listy popularnych baz danych NoSQL, która jest bezpłatną bazą danych o otwartym kodzie źródłowym, która jest rozproszona i ma szeroką kolumnową pamięć masową i może efektywnie obsługiwać dane w dużych klastrach towarowych, tj. Służy do zapewniają wysoką dostępność bez żadnego pojedynczego punktu awarii. Wśród listy głównych funkcji znajdują się takie, jak natura rozproszona, skalowalność, mechanizm odporności na awarie, obsługa MapReduce, dostrajalna spójność, właściwość języka zapytań, obsługuje replikację wielu centrów danych i ewentualną spójność.

4. Cassandra : Cassandra stanowi najlepszy wybór spośród listy popularnych baz danych NoSQL, która jest bezpłatną bazą danych o otwartym kodzie źródłowym, która jest rozproszona i ma szeroką kolumnową pamięć masową i może efektywnie obsługiwać dane w dużych klastrach towarowych, tj. Służy do zapewniają wysoką dostępność bez żadnego pojedynczego punktu awarii. Wśród listy głównych funkcji znajdują się takie, jak natura rozproszona, skalowalność, mechanizm odporności na awarie, obsługa MapReduce, dostrajalna spójność, właściwość języka zapytań, obsługuje replikację wielu centrów danych i ewentualną spójność.

Następnie możemy porozmawiać o różnych obszarach technologii big data, tj. Data Mining.

5. Presto : Jest to popularny silnik zapytań rozproszonych typu open source i oparty na SQL, który jest używany do uruchamiania interaktywnych zapytań w odniesieniu do źródeł danych każdej skali i zakresów wielkości od Gigabajtów do Petabajtów. Za jego pomocą możemy wyszukiwać dane w Cassandra, Hive, zastrzeżonych magazynach danych i systemach przechowywania relacyjnych baz danych. Jest to silnik zapytań oparty na języku Java, który został opracowany przez fundację Apache w 2013 roku. Kilka firm, które dobrze korzystają z narzędzia Presto, to Netflix, Airbnb, Checkr, Repro i Facebook.

5. Presto : Jest to popularny silnik zapytań rozproszonych typu open source i oparty na SQL, który jest używany do uruchamiania interaktywnych zapytań w odniesieniu do źródeł danych każdej skali i zakresów wielkości od Gigabajtów do Petabajtów. Za jego pomocą możemy wyszukiwać dane w Cassandra, Hive, zastrzeżonych magazynach danych i systemach przechowywania relacyjnych baz danych. Jest to silnik zapytań oparty na języku Java, który został opracowany przez fundację Apache w 2013 roku. Kilka firm, które dobrze korzystają z narzędzia Presto, to Netflix, Airbnb, Checkr, Repro i Facebook.

6. ElasticSearch : Jest to obecnie bardzo ważne narzędzie do wyszukiwania. Tworzy to istotny element stosu ELK, tj. Wyszukiwanie elastyczne, Logstash i Kibana. ElasticSearch to oparta na bibliotece Lucene wyszukiwarka, która jest podobna do Solr i jest używana do zapewnienia czysto rozproszonej, pełnotekstowej wyszukiwarki, która może obsługiwać wiele dzierżawców. Posiada listę dokumentów JSON bez schematu i interfejs WWW HTTP. Jest napisany w języku JAVA i jest rozwijany przez firmę Elastic w firmie w 2012 roku. Nazwami kilku firm korzystających z elasticsearch są: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture itp.

6. ElasticSearch : Jest to obecnie bardzo ważne narzędzie do wyszukiwania. Tworzy to istotny element stosu ELK, tj. Wyszukiwanie elastyczne, Logstash i Kibana. ElasticSearch to oparta na bibliotece Lucene wyszukiwarka, która jest podobna do Solr i jest używana do zapewnienia czysto rozproszonej, pełnotekstowej wyszukiwarki, która może obsługiwać wiele dzierżawców. Posiada listę dokumentów JSON bez schematu i interfejs WWW HTTP. Jest napisany w języku JAVA i jest rozwijany przez firmę Elastic w firmie w 2012 roku. Nazwami kilku firm korzystających z elasticsearch są: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture itp.

Przeczytajmy teraz o tych wszystkich technologiach big data, które są częścią analizy danych:

7. Apache Kafka : Znany z subskrybowania publikowania lub publikowania podrzędnego, ponieważ jest powszechnie znany jako, to bezpośredni broker asynchronicznego systemu przesyłania komunikatów, który jest wykorzystywany do pozyskiwania i przetwarzania danych w czasie rzeczywistym. Zapewnia również okres przechowywania, a dane mogą być kierowane za pomocą mechanizmu producent-konsument. Jest to jedna z najpopularniejszych platform przesyłania strumieniowego, która jest bardzo podobna do korporacyjnego systemu przesyłania wiadomości lub kolejki przesyłania wiadomości. Do tej pory Kafka wprowadziła wiele ulepszeń, a jednym z głównych jest konfluent Kafka, który zapewnia dodatkowy poziom właściwości Kafki, takich jak rejestr schematów, Ktables, KSql itp. Został on opracowany przez społeczność Apache Software w roku 2011 i jest napisany w Javie. Firmy korzystające z tej technologii to Twitter, Spotify, Netflix, Linkedin, Yahoo itp.

7. Apache Kafka : Znany z subskrybowania publikowania lub publikowania podrzędnego, ponieważ jest powszechnie znany jako, to bezpośredni broker asynchronicznego systemu przesyłania komunikatów, który jest wykorzystywany do pozyskiwania i przetwarzania danych w czasie rzeczywistym. Zapewnia również okres przechowywania, a dane mogą być kierowane za pomocą mechanizmu producent-konsument. Jest to jedna z najpopularniejszych platform przesyłania strumieniowego, która jest bardzo podobna do korporacyjnego systemu przesyłania wiadomości lub kolejki przesyłania wiadomości. Do tej pory Kafka wprowadziła wiele ulepszeń, a jednym z głównych jest konfluent Kafka, który zapewnia dodatkowy poziom właściwości Kafki, takich jak rejestr schematów, Ktables, KSql itp. Został on opracowany przez społeczność Apache Software w roku 2011 i jest napisany w Javie. Firmy korzystające z tej technologii to Twitter, Spotify, Netflix, Linkedin, Yahoo itp.

8. Splunk : Splunk służy do przechwytywania, korelowania i indeksowania danych przesyłanych strumieniowo w czasie rzeczywistym z repozytorium z możliwością wyszukiwania, z którego może generować raporty, wykresy, pulpity nawigacyjne, alerty i wizualizacje danych. Służy również do zarządzania bezpieczeństwem, zgodnością i aplikacjami, a także do analityki internetowej, generowania informacji biznesowych i analiz biznesowych. Został opracowany przez Splunk w Python, XML, Ajax.

8. Splunk : Splunk służy do przechwytywania, korelowania i indeksowania danych przesyłanych strumieniowo w czasie rzeczywistym z repozytorium z możliwością wyszukiwania, z którego może generować raporty, wykresy, pulpity nawigacyjne, alerty i wizualizacje danych. Służy również do zarządzania bezpieczeństwem, zgodnością i aplikacjami, a także do analityki internetowej, generowania informacji biznesowych i analiz biznesowych. Został opracowany przez Splunk w Python, XML, Ajax.

9. Apache Spark : Teraz pojawia się najbardziej krytyczna i najbardziej oczekiwana technologia w dziedzinie technologii Big Data, tj. Apache Spark. Prawdopodobnie należy do tych, które są obecnie najbardziej poszukiwane i do przetwarzania wykorzystuje Javę, Scalę lub Pythona. Służy do przetwarzania i obsługi danych przesyłanych strumieniowo w czasie rzeczywistym za pomocą Spark Streaming, który wykorzystuje do tego celu operacje grupowania i okienkowania. Spark SQL służy do tworzenia ramek danych, zestawów danych na dyskach RDD, a tym samym zapewnia dobry smak transformacji i działań, które stanowią integralny element Apache Spark Core. Inne komponenty, takie jak Spark Mllib, R i graphX, są również przydatne w przypadku analizy i uczenia maszynowego i analizy danych. Technika obliczeń w pamięci różni się od innych narzędzi i komponentów i obsługuje wiele różnych aplikacji. Został on opracowany przez fundację Apache Software przede wszystkim w języku Java.

9. Apache Spark : Teraz pojawia się najbardziej krytyczna i najbardziej oczekiwana technologia w dziedzinie technologii Big Data, tj. Apache Spark. Prawdopodobnie należy do tych, które są obecnie najbardziej poszukiwane i do przetwarzania wykorzystuje Javę, Scalę lub Pythona. Służy do przetwarzania i obsługi danych przesyłanych strumieniowo w czasie rzeczywistym za pomocą Spark Streaming, który wykorzystuje do tego celu operacje grupowania i okienkowania. Spark SQL służy do tworzenia ramek danych, zestawów danych na dyskach RDD, a tym samym zapewnia dobry smak transformacji i działań, które stanowią integralny element Apache Spark Core. Inne komponenty, takie jak Spark Mllib, R i graphX, są również przydatne w przypadku analizy i uczenia maszynowego i analizy danych. Technika obliczeń w pamięci różni się od innych narzędzi i komponentów i obsługuje wiele różnych aplikacji. Został on opracowany przez fundację Apache Software przede wszystkim w języku Java.

10. Język R : R jest językiem programowania i środowiskiem wolnego oprogramowania używanym do obliczeń statystycznych, a także do grafiki w jednym z najważniejszych języków w języku R. Jest to jeden z najpopularniejszych języków wśród naukowców, eksploratorów danych i specjalistów ds. danych do opracowywania oprogramowania statystycznego, a przede wszystkim do analizy danych.

10. Język R : R jest językiem programowania i środowiskiem wolnego oprogramowania używanym do obliczeń statystycznych, a także do grafiki w jednym z najważniejszych języków w języku R. Jest to jeden z najpopularniejszych języków wśród naukowców, eksploratorów danych i specjalistów ds. danych do opracowywania oprogramowania statystycznego, a przede wszystkim do analizy danych.

Omówmy teraz technologie związane z wizualizacją danych.

11. Tableau: Jest to najszybsze i najmocniejsze narzędzie do wizualizacji danych, które jest używane w domenie Business Intelligence. Analiza danych jest bardzo szybką maszyną, która jest możliwa za pomocą Tableau, a wizualizacje są tworzone w postaci arkuszy roboczych i pulpitów nawigacyjnych. Został opracowany przez firmę tableau w 2013 roku i jest napisany w Python, C ++, Java i C. Firmami korzystającymi z Tableau są: QlikQ, Oracle Hyperion, Cognos itp.

11. Tableau: Jest to najszybsze i najmocniejsze narzędzie do wizualizacji danych, które jest używane w domenie Business Intelligence. Analiza danych jest bardzo szybką maszyną, która jest możliwa za pomocą Tableau, a wizualizacje są tworzone w postaci arkuszy roboczych i pulpitów nawigacyjnych. Został opracowany przez firmę tableau w 2013 roku i jest napisany w Python, C ++, Java i C. Firmami korzystającymi z Tableau są: QlikQ, Oracle Hyperion, Cognos itp.

12. Plotly : Plotly służy głównie do szybszego i bardziej wydajnego tworzenia wykresów i powiązanych komponentów. Ma bogatszy zestaw bibliotek i interfejsów API, takich jak MATLAB, Python, R, Arduino, Julia itp. Można z nich korzystać interaktywnie w notatniku Jupyter i Pycharm, a także do stylizowania interaktywnych wykresów. Po raz pierwszy został opracowany w 2012 roku i napisany w javascript. Nieliczne firmy, które używają Plotly, to paladyny, bitbank itp.

12. Plotly : Plotly służy głównie do szybszego i bardziej wydajnego tworzenia wykresów i powiązanych komponentów. Ma bogatszy zestaw bibliotek i interfejsów API, takich jak MATLAB, Python, R, Arduino, Julia itp. Można z nich korzystać interaktywnie w notatniku Jupyter i Pycharm, a także do stylizowania interaktywnych wykresów. Po raz pierwszy został opracowany w 2012 roku i napisany w javascript. Nieliczne firmy, które używają Plotly, to paladyny, bitbank itp.

Wniosek

W tym poście przeanalizowaliśmy najlepsze technologie dużych zbiorów danych, które są dziś szeroko stosowane. Mam nadzieje ze ci się podobało. Śledź nas na więcej takich postów.

Polecane artykuły

To jest przewodnik po technologiach Big Data. Tutaj omówiliśmy wprowadzenie i rodzaje technologii Big Data. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Co to jest Splunk Tool?

- R vs Python

- Co to jest Matlab?

- Co to jest MongoDB?

- Kroki, które należy wykonać w testowaniu komputerów mainframe

- Rodzaje złączeń w Spark SQL (przykłady)

- Naucz się różnych rodzajów narzędzi Kafka