Wprowadzenie do metod jądra w uczeniu maszynowym

Algorytm wykorzystywany do analizy wzorców jest nazywany metodą jądra w uczeniu maszynowym. Ogólnie rzecz biorąc, przeprowadzana jest analiza w celu znalezienia relacji w zestawach danych. Relacjami tymi mogą być grupowanie, klasyfikacja, główne komponenty, korelacja itp. Większość algorytmów, które rozwiązują te zadania analizy wzorca, potrzebują danych w postaci reprezentatywnej, aby zostały jawnie przekształcone w reprezentację wektora cech. Ta transformacja może być wykonana za pomocą mapy obiektów określonej przez użytkownika. Można więc przyjąć, że metoda jądra wymaga tylko jądra określonego przez użytkownika.

Terminologia Kernal Method wynika z faktu, że używają funkcji jądra, co pozwala im wykonywać operację w wielowymiarowej, niejawnej przestrzeni cech bez potrzeby obliczania współrzędnych danych w tej przestrzeni. Zamiast tego po prostu obliczają iloczyn wewnętrzny między obrazami wszystkich par danych w przestrzeni obiektów.

Tego rodzaju operacje są przez większość czasu tańsze obliczeniowo w porównaniu do jawnego obliczania współrzędnych. Ta technika jest określana jako „sztuczka jądra”. Każdy model liniowy można przekształcić w model nieliniowy, stosując sztuczkę jądra do modelu.

Metoda jądra dostępna w uczeniu maszynowym to analiza głównych komponentów (PCA), grupowanie widmowe, maszyny wektorów nośnych (SVM), analiza korelacji kanonicznej, perceptron jądra, procesy Gaussa, regresja grzbietu, liniowe filtry adaptacyjne i wiele innych. Przyjrzyjmy się na wysokim poziomie kilku z tych metod jądra.

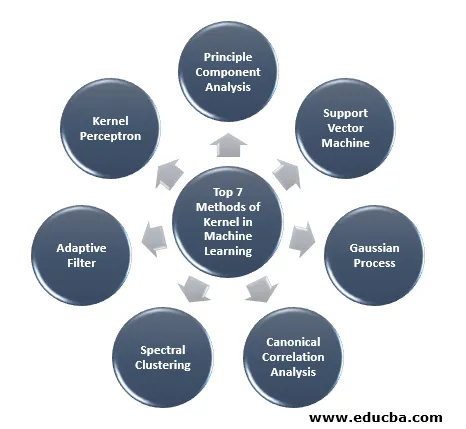

Top 7 metod jądra w uczeniu maszynowym

Poniżej wymieniono metody jądra w uczeniu maszynowym:

1. Zasada Analiza komponentów

Analiza głównych składników (PCA) to technika wydobywania struktury z możliwie wysokowymiarowych zbiorów danych. Można to łatwo wykonać przy użyciu algorytmów iteracyjnych, które szacują główne składniki lub rozwiązując problem wartości własnych. PCA to ortogonalna transformacja układu współrzędnych, w której opisujemy nasze dane. Nowy układ współrzędnych jest uzyskiwany przez rzutowanie na główne osie danych. Niewielka liczba głównych składników jest często wystarczająca do uwzględnienia większości struktury danych. Jednym z jego głównych zastosowań jest przeprowadzenie eksploracyjnej analizy danych w celu stworzenia modelu predykcyjnego. Najczęściej służy do wizualizacji powiązań między populacjami a odległością genetyczną.

2. Obsługa maszyny wektorowej

SVM można zdefiniować jako klasyfikator do oddzielania hiperpłaszczyzny, gdzie hiperpłaszczyzna jest podprzestrzenią o jeden wymiar mniejszą niż przestrzeń otoczenia. Wymiar tej przestrzeni matematycznej jest definiowany jako minimalna liczba współrzędnych wymaganych do określenia dowolnego punktu, podczas gdy przestrzeń otoczenia jest przestrzenią otaczającą obiekt matematyczny. Teraz przedmiot matematyczny można rozumieć jako obiekt abstrakcyjny, który nie istnieje w żadnym momencie ani miejscu, ale istnieje jako rodzaj rzeczy.

3. Proces Gaussa

Proces Gaussa został nazwany na cześć Carka Friedricha Gaussa, ponieważ wykorzystuje zapis rozkładu Gaussa (rozkład normalny). Jest to proces stochastyczny, co oznacza zbiór losowych zmiennych indeksowanych według czasu lub przestrzeni. W Procesie Gaussa zmienne losowe mają wielowymiarowy rozkład normalny, tzn. Wszystkie ich skończone kombinacje liniowe są zwykle rozkładane. Proces Gaussa wykorzystuje właściwości odziedziczone z rozkładu normalnego i dlatego są użyteczne w modelowaniu statystycznym. Algorytm uczenia maszynowego, który obejmuje tę metodę jądra, wykorzystuje miarę leniwego uczenia się i podobieństwa między punktami, aby przewidzieć wartość niewidocznych punktów na podstawie danych treningowych. Ta prognoza to nie tylko szacunek, ale i niepewność w tym momencie.

4. Kanoniczna analiza korelacji

Kanoniczna analiza korelacji jest sposobem wnioskowania informacji z macierzy między kowariancji. Jest również znany jako analiza zmiennych kanonicznych. Załóżmy, że mamy dwa wektor X, Y zmiennej losowej, powiedzmy, że dwa wektory X = (X1, …, Xn) i wektor Y = (Y1, …, Ym) i zmienna mająca korelację, wówczas CCA obliczy liniową kombinację X i Y, który ma maksymalną korelację między sobą.

5. Grupowanie widmowe

W zastosowaniu segmentacji obrazu klaster widmowy jest znany jako kategoryzacja obiektów oparta na segmentacji. W klastrowaniu spektralnym redukcja wymiarów jest wykonywana przed grupowaniem w mniejszym wymiarze, odbywa się to za pomocą wartości własnej macierzy podobieństwa danych. Ma swoje korzenie w teorii grafów, gdzie to podejście służy do identyfikacji społeczności węzłów na wykresie, który jest oparty na łączących je krawędziach. Ta metoda jest wystarczająco elastyczna i pozwala nam również grupować dane z wykresów innych niż wykresy.

6. Filtr adaptacyjny

Filtr adaptacyjny wykorzystuje filtr liniowy, który zawiera funkcję przenoszenia, która jest kontrolowana przez zmienne parametry i metody, które zostaną wykorzystane do poprawienia tych parametrów zgodnie z algorytmem optymalizacji. Złożoność tego algorytmu optymalizacji powoduje, że wszystkie filtry adaptacyjne są filtrami cyfrowymi. Filtr adaptacyjny jest potrzebny w tych aplikacjach, w których nie ma wcześniejszych informacji o pożądanej operacji przetwarzania lub są one zmieniane.

Funkcja kosztu jest wykorzystywana w filtrze adaptacyjnym w zamkniętej pętli, ponieważ jest to konieczne dla optymalnej wydajności filtra. Określa sposób modyfikacji funkcji przesyłania filtra, aby zmniejszyć koszt następnej iteracji. Jedną z najczęstszych funkcji jest średni błąd kwadratowy sygnału błędu.

7. Perceptron jądra

W uczeniu maszynowym perceptron jądra jest rodzajem popularnego algorytmu uczenia się perceptronu, który może uczyć się maszyn jądra, takich jak nieliniowe klasyfikatory, które używają funkcji jądra do obliczania podobieństwa tych próbek, które są niewidoczne dla próbek szkoleniowych. Algorytm ten został wynaleziony w 1964 roku, dzięki czemu stał się pierwszym uczniem klasyfikacji jądra.

Większość omawianych algorytmów jądra opiera się na optymalizacji wypukłej lub problemach własnych i jest statystycznie uzasadniona. Ich właściwości statystyczne są analizowane przy użyciu statystycznej teorii uczenia się.

Mówiąc o obszarach zastosowania metod jądra, jest on różnorodny i obejmuje geostatystykę, kriging, odwrotne ważenie odległości, rekonstrukcję 3D, bioinformatykę, chemoinformatykę, ekstrakcję informacji i rozpoznawanie pisma ręcznego.

Wniosek

Podsumowałem niektóre terminologie i typy metod jądra w uczeniu maszynowym. Ze względu na brak miejsca, ten artykuł w żadnym wypadku nie jest wyczerpujący i ma na celu wyjaśnienie, czym jest metoda jądra oraz krótkie podsumowanie jej rodzajów. Jednak omówienie tego artykułu sprawi, że zrobisz pierwszy krok w dziedzinie uczenia maszynowego.

Polecane artykuły

Jest to przewodnik po Metodzie jądra w uczeniu maszynowym. Tutaj omawiamy 7 typów metod jądra w uczeniu maszynowym. Możesz także spojrzeć na następujący artykuł.

- Jądro monolityczne

- Grupowanie w uczenie maszynowe

- Uczenie maszynowe danych

- Uczenie maszynowe bez nadzoru

- Filtry PHP | Jak sprawdzić poprawność danych wprowadzanych przez użytkownika za pomocą różnych filtrów?

- Kompletny przewodnik po cyklu życia uczenia maszynowego