Różnica pomiędzy Małe dane i duże zbiory danych

Małe dane to nic innego, jak dane wystarczająco obszerne dla człowieka w wolumenie, a także do formatowania, dzięki czemu są one dostępne, informacyjne i przydatne. Tradycyjne przetwarzanie danych nie jest w stanie poradzić sobie z dużymi lub złożonymi danymi, które są określane jako Big Data. Gdy ilość danych przekracza określony limit, tradycyjne systemy i metodologie nie wystarczą do przetworzenia danych lub przekształcenia danych w przydatny format. Właśnie dlatego dane są ogólnie podzielone na dwie części - Małe dane vs. Duże zbiory danych

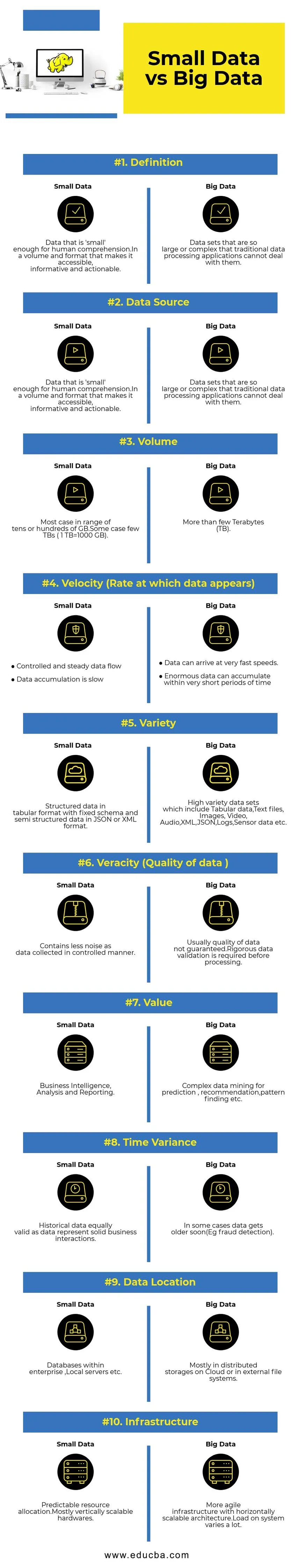

Bezpośrednie porównanie między małymi danymi a dużymi danymi (Infografika)

Poniżej znajduje się 10 najważniejszych różnic między małymi i dużymi danymi

Kluczowe różnice między małymi danymi a dużymi danymi

- Zbieranie danych - zwykle małe dane są częścią systemów OLTP i są gromadzone w bardziej kontrolowany sposób, a następnie wstawiane do warstwy buforującej lub bazy danych. W razie potrzeby bazy danych będą miały repliki odczytu do obsługi natychmiastowych zapytań analitycznych. Rurociąg gromadzenia dużych zbiorów danych będzie zawierał kolejki takie jak AWS Kinesis lub Google Pub / Sub w celu zrównoważenia danych o dużej prędkości. Downstream będzie miał potoki przesyłania strumieniowego do analiz w czasie rzeczywistym i zadań wsadowych do zimnego przetwarzania danych.

- Przetwarzanie danych - Ponieważ większość małych danych generowanych przez system transakcyjny, analizy nad nim będą przez większość czasu zorientowane na partię. W niektórych rzadkich przypadkach zapytania analityczne są uruchamiane bezpośrednio na systemach transakcyjnych. Środowiska Big Data będą miały potoki przetwarzania wsadowego i strumieniowego. Strumień służy do analiz w czasie rzeczywistym, takich jak wykrywanie oszustw związanych z kartami kredytowymi lub prognozowanie cen akcji. Przetwarzanie wsadowe wykorzystywane do implementacji złożonej logiki biznesowej z danymi i zaawansowanymi algorytmami.

- Skalowalność - małe systemy danych zazwyczaj skalują się w pionie. Skalowanie w pionie zwiększa pojemność systemu, dodając więcej zasobów do tej samej maszyny. Skalowanie w pionie jest kosztowne, ale mniej skomplikowane w zarządzaniu. Systemy Big Data zależą głównie od architektury skalowalnej w poziomie, która zapewnia większą zwinność przy niższym koszcie. Wstrzymujące maszyny wirtualne dostępne w chmurze sprawiają, że systemy skalowalne w poziomie są jeszcze bardziej przystępne.

- Modelowanie danych - Małe dane generowane z systemów transakcyjnych będą w znormalizowanej formie. Rurociągi danych w formacie ETL (Extract Transform Load) przekształcają je w schemat gwiazdy lub płatka śniegu w hurtowni danych. Tutaj schemat jest zawsze egzekwowany podczas zapisywania danych, co jest stosunkowo łatwe, ponieważ dane są bardziej uporządkowane. Jak wspomniano powyżej, dane tabelaryczne to tylko ułamek Big Data. Tutaj dane są replikowane znacznie bardziej z różnych powodów, takich jak przekazywanie awarii lub z powodu pewnych ograniczeń bazowego silnika bazy danych (na przykład niektóre bazy danych obsługują tylko jeden indeks wtórny na zestaw danych). Schemat nie jest egzekwowany podczas pisania. Zamiast tego schemat jest sprawdzany podczas odczytu danych.

- Sprzężenie pamięci i obliczeń - w tradycyjnych bazach danych, które głównie obsługują małe dane, przechowywanie i przetwarzanie danych są ze sobą ściśle powiązane. Wkładanie i pobieranie danych do bazy danych i z bazy danych jest możliwe tylko za pośrednictwem danego interfejsu. Danych nie można umieścić bezpośrednio w systemie plików bazy danych, ani nie można przeszukiwać istniejących danych za pomocą innych silników DB. W rzeczywistości ta architektura bardzo pomaga zapewnić integralność danych. Systemy Big Data mają bardzo luźne połączenie między pamięcią masową a obliczeniami. Zwykle dane są przechowywane w rozproszonym systemie przechowywania danych, takim jak HDFS, AWS S3 lub Google GCS i silnik obliczeniowy, który wyszukuje dane lub wykonuje ETL wybrany później. Na przykład zapytania interaktywne mogą być wykonywane przy użyciu Presto (Link) i ETL przy użyciu Apache Hive na tych samych danych.

- Nauka danych - Algorytmy uczenia maszynowego wymagają danych wejściowych w dobrze ustrukturyzowanym i odpowiednio zakodowanym formacie, a większość danych wejściowych będzie pochodzić zarówno z systemów transakcyjnych, takich jak hurtownia danych, jak i pamięć Big Data, jak jezioro danych. Algorytmy uczenia maszynowego działające wyłącznie na małych danych będą łatwe, ponieważ etap przygotowania danych jest wąski. Przygotowywanie i wzbogacanie danych w środowisku Big Data zajmuje znacznie więcej czasu. Big Data daje wiele możliwości eksperymentowania z naukami o danych ze względu na dużą ilość i różnorodność danych.

- Bezpieczeństwo danych - praktyki bezpieczeństwa dla małych danych, które znajdują się w hurtowniach danych lub systemach transakcyjnych dostarczanych przez odpowiednich dostawców baz danych, które mogą obejmować uprawnienia użytkownika, szyfrowanie danych, mieszanie itp. Zabezpieczanie systemów Big Data jest znacznie bardziej skomplikowane i trudne. Najlepsze praktyki bezpieczeństwa obejmują szyfrowanie danych w spoczynku i transporcie, izolowanie sieci klastrowej, rygorystyczne reguły kontroli dostępu itp.

Tabela porównawcza małych danych a dużych zbiorów danych

| Podstawa porównania | Małe dane | Big Data |

| Definicja | Dane, które są „wystarczająco małe” dla ludzkiego zrozumienia, w objętości i formacie, który czyni je dostępnymi, pouczającymi i praktycznymi | Zestawy danych, które są tak duże lub złożone, że tradycyjne aplikacje do przetwarzania danych nie mogą sobie z nimi poradzić |

| Źródło danych | ● Dane z tradycyjnych systemów korporacyjnych, takich jak Planning Planowanie zasobów przedsiębiorstwa ○ Zarządzanie relacjami z klientami (CRM) ● Dane finansowe, takie jak dane księgi głównej ● Dane transakcji płatniczych ze strony internetowej | ● Kupuj dane w punkcie sprzedaży ● Dane Clickstream ze stron internetowych ● Dane strumienia GPS - Dane mobilności wysyłane do serwera ● Media społecznościowe - Facebook, Twitter |

| Tom | Większość przypadków mieści się w zakresie dziesiątek lub setek GB. Niektóre przypadki to kilka TB (1 TB = 1000 GB) | Więcej niż kilka terabajtów (TB) |

| Prędkość (szybkość, z jaką pojawiają się dane) | ● Kontrolowany i stały przepływ danych ● Gromadzenie danych jest powolne | ● Dane mogą docierać z bardzo dużą prędkością. ● Ogromne dane mogą się gromadzić w bardzo krótkim czasie |

| Różnorodność | Dane strukturalne w formacie tabelarycznym ze stałym schematem i dane częściowo ustrukturyzowane w formacie JSON lub XML | Zestawy danych o dużej różnorodności, które obejmują dane tabelaryczne, pliki tekstowe, obrazy, wideo, audio, XML, JSON, logi, dane z czujników itp. |

| Prawdziwość (jakość danych) | Zawiera mniej hałasu, ponieważ dane są gromadzone w kontrolowany sposób. | Zwykle jakość danych nie jest gwarantowana. Przed przetwarzaniem wymagana jest ścisła weryfikacja danych. |

| Wartość | Analiza biznesowa, analiza i raportowanie | Złożone wyszukiwanie danych w celu przewidywania, rekomendacji, wyszukiwania wzorców itp. |

| Zróżnicowanie czasu | Dane historyczne są równie ważne, ponieważ dane reprezentują solidne interakcje biznesowe | W niektórych przypadkach dane wkrótce się starzeją (np. Wykrywanie oszustw). |

| Lokalizacja danych | Bazy danych w przedsiębiorstwie, serwery lokalne itp. | Głównie w rozproszonych magazynach w chmurze lub w zewnętrznych systemach plików. |

| Infrastruktura | Przewidywalna alokacja zasobów, głównie pionowo skalowalny sprzęt | Zwinniejsza infrastruktura dzięki skalowalnej w poziomie architekturze. Obciążenie systemu jest bardzo różne. |

Wniosek - małe dane a duże zbiory danych

Ostatecznym celem analizy danych jest uzyskanie wglądu we właściwym czasie w celu wsparcia procesu decyzyjnego. Podział danych na małe i duże pomaga stawić czoła wyzwaniom związanym z analizowaniem danych z każdego świata osobno za pomocą odpowiednich narzędzi. Granica między dwiema kategoriami różni się w zależności od pojawiających się zaawansowanych systemów przetwarzania danych, co sprawia, że nawet wyszukiwanie dużych danych jest znacznie szybsze i mniej złożone.

Polecane artykuły:

Jest to przewodnik po małych danych w porównaniu z dużymi danymi, ich znaczeniu, bezpośrednim porównaniu, kluczowymi różnicami, tabelą porównawczą i wnioskami. ten artykuł zawiera wszystkie ważne różnice między małymi i dużymi danymi. Możesz także przejrzeć następujące artykuły, aby dowiedzieć się więcej -

- Big Data vs Data Science - czym się różnią?

- Big Data: Ważne z punktu widzenia zbieżności technologii i analityki biznesowej

- Top 5 trendów Big Data, które firmy będą musiały opanować

- 16 interesujących wskazówek na temat przekształcania dużych zbiorów danych w wielki sukces