Przegląd instalacji Hadoop

Poniższy artykuł, Zainstaluj Hadoop zawiera zarys najpopularniejszych kluczowych modułów frameworka Hadoop i krok po kroku instalacji Hadoop. Apache Hadoop to zbiór oprogramowania, które umożliwia przetwarzanie dużych zbiorów danych i rozproszonej pamięci masowej w klastrze różnych typów systemu komputerowego. Obecnie Hadoop pozostaje najczęściej używaną platformą analityczną dla dużych zbiorów danych („Sanchita Lobo, autorka na Blogu Szkoleniowym Analytics” i drugim).

Hadoop Framework

Struktura Apache Hadoop składa się z następujących kluczowych modułów.

- Apache Hadoop Common.

- Rozproszony system plików Apache Hadoop (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (Yet Another Resource Manager).

Apache Hadoop Common

Wspólny moduł Apache Hadoop składa się z bibliotek współdzielonych, które są wykorzystywane we wszystkich innych modułach, w tym do zarządzania kluczami, ogólnych pakietów we / wy, bibliotek do gromadzenia metryk oraz narzędzi do rejestru, bezpieczeństwa i przesyłania strumieniowego.

HDFS

System plików HDFS oparty jest na systemie plików Google i jest przystosowany do działania na niedrogim sprzęcie. HDFS jest odporny na błędy i jest przeznaczony do aplikacji o dużych zestawach danych.

MapReduce

MapReduce jest nieodłącznym modelem programowania równoległego do przetwarzania danych, a Hadoop może uruchamiać programy MapReduce napisane w różnych językach, takich jak Java. MapReduce działa poprzez podział przetwarzania na fazę mapy i zmniejsza fazę.

Przędza Apache Hadoop

YARN Apache Hadoop jest kluczowym składnikiem i jest technologią zarządzania zasobami i planowania zadań w rozproszonym środowisku przetwarzania Hadoop.

W tym artykule omówimy instalację i konfigurację Hadoop 2.7.4 w klastrze z jednym węzłem i przetestujemy konfigurację, uruchamiając program MapReduce o nazwie wordcount, aby policzyć liczbę słów w pliku. Przyjrzymy się dalej kilku ważnym poleceniom systemu plików Hadoop.

Kroki, aby zainstalować Hadoop

Poniżej znajduje się podsumowanie zadań związanych z konfiguracją Apache Hadoop.

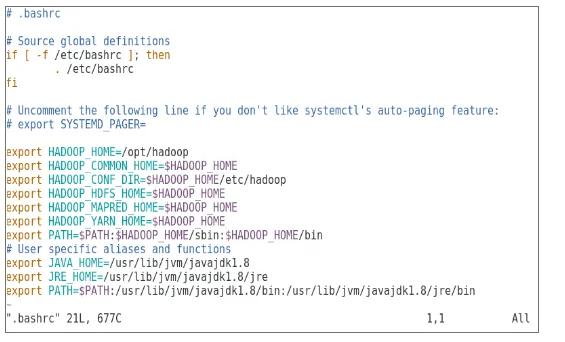

Zadanie 1: Pierwsze zadanie w instalacji Hadoop obejmowało skonfigurowanie szablonu maszyny wirtualnej skonfigurowanego w Cent OS7. Pakiety takie jak Java SDK 1.8 i Runtime Systems wymagane do uruchomienia Hadoop zostały pobrane, a zmienna środowiskowa Java dla Hadoop została skonfigurowana poprzez edycję bash_rc.

Zadanie 2: Pakiet Hadoop Release 2.7.4 został pobrany ze strony internetowej Apache i wyodrębniony w folderze opt. Który został następnie przemianowany na Hadoop dla łatwego dostępu.

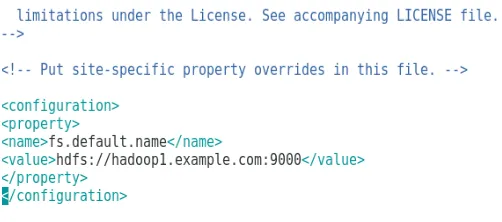

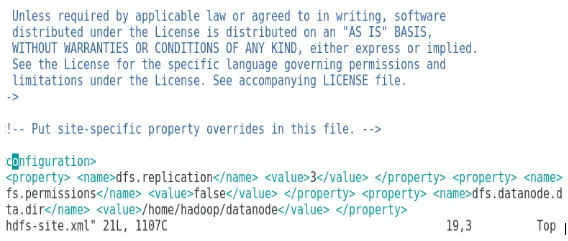

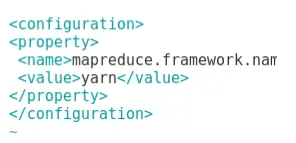

Zadanie 3: Po wyodrębnieniu pakietów Hadoop następnym krokiem było skonfigurowanie zmiennej środowiskowej dla użytkownika Hadoop, a następnie skonfigurowanie plików XML węzła Hadoop. W tym kroku NameNode został skonfigurowany w pliku core-site.xml, a DataNode został skonfigurowany w pliku hdfs-site.xml. Menedżer zasobów i menedżer węzłów zostały skonfigurowane w pliku yarn-site.xml.

Zadanie 4: Zapora została wyłączona w celu uruchomienia YARN i DFS. Komenda JPS została użyta do sprawdzenia, czy odpowiednie demony działają w tle. Numer portu umożliwiającego dostęp do Hadoop został skonfigurowany na http: // localhost: 50070 /

Zadanie 5: Kilka kolejnych kroków posłużyło do zweryfikowania i przetestowania Hadoop. W tym celu utworzyliśmy tymczasowy plik testowy w katalogu wejściowym programu WordCount. Do policzenia liczby słów w pliku zastosowano program Hadoop-MapReduce-Examples2.7.4.jar. Wyniki oceniono na localhost i przeanalizowano logi złożonego wniosku. Wszystkie przesłane aplikacje MapReduce można wyświetlić w interfejsie online, domyślny numer portu to 8088.

Zadanie 6: W ostatnim zadaniu wprowadzimy kilka podstawowych poleceń systemu plików Hadoop i sprawdzimy ich zastosowania. Zobaczymy, jak można utworzyć katalog w systemie plików Hadoop, aby wyświetlić zawartość katalogu, jego rozmiar w bajtach. Zobaczymy też, jak usunąć określony katalog i plik.

Wyniki instalacji Hadoop

Poniżej przedstawiono wyniki każdego z powyższych zadań:

Wynik zadania 1

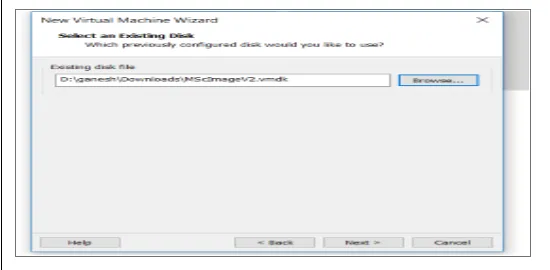

Nowa maszyna wirtualna z obrazem cenOS7 została skonfigurowana do uruchamiania Apache Hadoop. Rysunek 1 pokazuje, jak obraz CenOS 7 został skonfigurowany na maszynie wirtualnej. Rysunek 1.2 pokazuje konfigurację zmiennych środowiskowych JAVA w .bash_rc.

Rysunek 1: Konfiguracja maszyny wirtualnej

Rysunek 1.2: Konfiguracja zmiennych środowiskowych Java

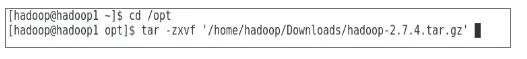

Wynik zadania 2

Ryc. 2 pokazuje zadanie wykonane w celu wyodrębnienia pakietu Hadoop 2.7.4 w folderze opt.

Rysunek 2: Ekstrakcja pakietu Hadoop 2.7.4

Wynik zadania 3

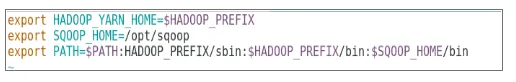

Rysunek 3 pokazuje konfigurację zmiennej środowiskowej dla użytkownika Hadoop, rysunek 3.1 do 3.4 pokazuje konfigurację plików XML wymaganych do konfiguracji Hadoop.

Rysunek 3: Konfigurowanie zmiennej środowiskowej dla użytkownika Hadoop

Rysunek 3.1: Konfiguracja pliku core-site.xml

Rysunek 3.2: Konfiguracja pliku hdfs-site.xml

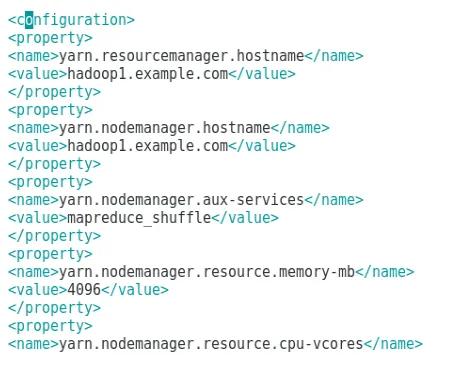

Rysunek 3.3: Konfiguracja pliku mapred-site.xml

Rysunek 3.4: Konfiguracja pliku yarn-site.xml

Wynik zadania 4

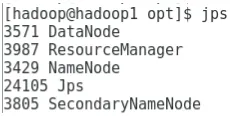

Rysunek 4 pokazuje użycie polecenia jps do sprawdzenia, czy odpowiednie demony działają w tle, a poniższy rysunek pokazuje internetowy interfejs użytkownika Hadoop.

Rysunek 4: polecenie jps w celu weryfikacji uruchomionych demonów.

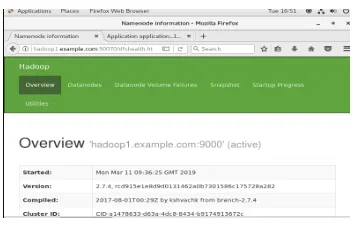

Rysunek 4.1: Dostęp do interfejsu online Hadoop na porcie http://hadoop1.example.com:50070/

Wynik zadania 5

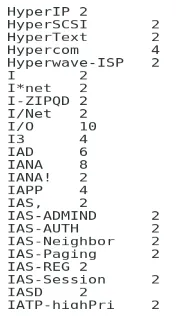

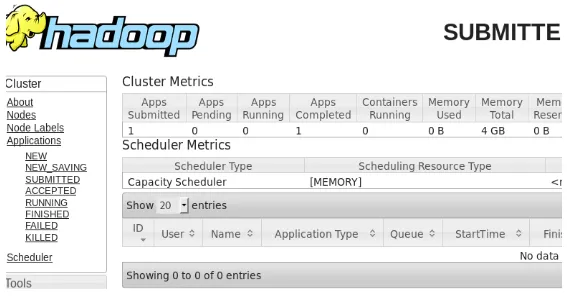

Rysunek 5 pokazuje wynik programu MapReduce o nazwie wordcount, który zlicza liczbę słów w pliku. Następne kilka rysunków pokazuje internetowy interfejs menedżera zasobów YARN dla przesłanego zadania.

Rysunek 5: Wyniki programu MapReduce

Rysunek 5.1: Przesłana aplikacja zmniejszania mapy.

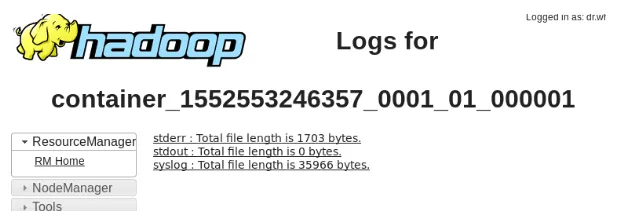

Rysunek 5.2: Logi dla przesłanej aplikacji MapReduce.

Wynik zadania 6

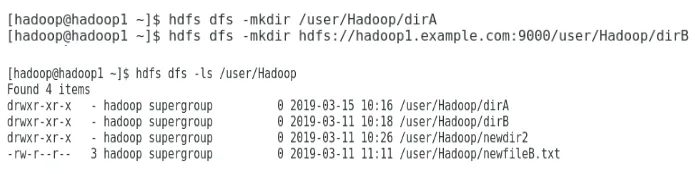

Rysunek 6 pokazuje, jak utworzyć katalog w systemie plików Hadoop i wykonać listę katalogu hdfs.

Rysunek 6: Tworzenie katalogu w systemie plików Hadoop

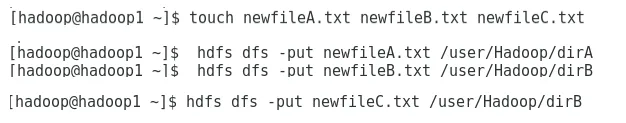

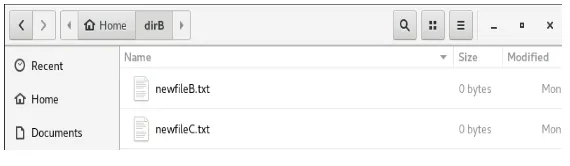

Rysunek 6.1 pokazuje, jak umieścić plik w rozproszonym systemie plików Hadoop, a rysunek 6.2 pokazuje utworzony plik w katalogu dirB.

Rysunek 6.1: Tworzenie pliku w HDFS.

Rysunek 6.2: Utworzono nowy plik.

Następne kilka rysunków pokazuje, jak wyświetlić zawartość poszczególnych katalogów:

Rysunek 6.3: Treść dirA

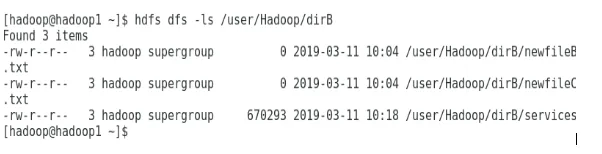

Rysunek 6.4: Zawartość katalogu dirB

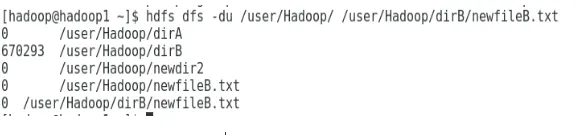

Następny rysunek pokazuje, jak można wyświetlić rozmiar pliku i katalogu:

Rysunek 6.5: Wyświetl rozmiar pliku i katalogu.

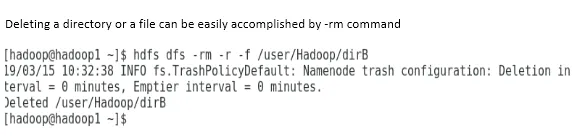

Usunięcie katalogu lub pliku można łatwo wykonać za pomocą polecenia -rm.

Rysunek 6.6: Aby usunąć plik.

Wniosek

Big Data odegrał bardzo ważną rolę w kształtowaniu dzisiejszego rynku światowego. Struktura Hadoop ułatwia życie analityka danych podczas pracy na dużych zestawach danych. Konfiguracja Apache Hadoop była dość prosta, a interfejs użytkownika online zapewnił użytkownikowi wiele opcji dostrajania aplikacji i zarządzania nią. Hadoop był szeroko stosowany w organizacjach do przechowywania danych, analityki uczenia maszynowego i tworzenia kopii zapasowych danych. Zarządzanie dużą ilością danych było bardzo przydatne ze względu na środowisko rozproszone Hadoop i MapReduce. Rozwój Hadoop był niesamowity w porównaniu z relacyjnymi bazami danych, ponieważ brakuje im opcji dostrajania i wydajności. Apache Hadoop to przyjazne dla użytkownika i tanie rozwiązanie do wydajnego zarządzania i przechowywania dużych zbiorów danych. System plików HDFS również pomaga w przechowywaniu danych.

Polecane artykuły

To jest przewodnik po instalacji Hadoop. Tutaj omawiamy wprowadzenie do Instal Hadoop, krok po kroku instalację Hadoop wraz z wynikami instalacji Hadoop. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Wprowadzenie do przesyłania strumieniowego Hadoop

- Co to jest klaster Hadoop i jak działa?

- Ekosystem Apache Hadoop i jego składniki

- Jakie są alternatywy dla Hadoop?