Co to jest świnia?

Pig to silnik typu open source, który jest częścią technologii ekosystemu Hadoop. Pig jest świetny w pracy z danymi, które wykraczają poza tradycyjne bazy danych lub hurtownie danych. Może to dobrze poradzić sobie z brakującymi, niekompletnymi lub niespójnymi danymi, które nie mają schematu. Świnia ma swój własny język do wyrażania manipulacji danymi, którym jest świnia łacińska.

Zrozumienie Świni

Pig to technologia umożliwiająca pisanie skryptów wysokiego poziomu, ale bardzo szczegółowych, co umożliwia pracę z danymi, w których schemat jest nieznany lub niespójny. Pig to technologia open source, która działa na platformie Hadoop i jest częścią niezwykle żywego i popularnego ekosystemu Hadoop.

Świnia działa dobrze z nieustrukturyzowanymi i niekompletnymi danymi, więc nie musisz mieć tradycyjnego układu reguł i kolumn do wszystkiego.

Jest dobrze zdefiniowany i może bezpośrednio pracować na plikach w HDFS (Hadoop Distributed File System).

Świnia będzie Twoją technologią z wyboru, gdy chcesz pobrać dane ze źródła do hurtowni danych.

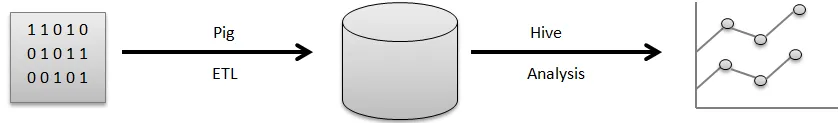

Na przykład wizualny potok przepływu danych, zanim będzie można go użyć do wygenerowania ładnych wykresów używanych do podejmowania decyzji biznesowych.

Surowe dane pochodzą z różnych źródeł, takich jak czujniki, telefony komórkowe itp. Następnie użyjesz Pig do wykonania operacji ETL. ETL oznacza wyodrębnianie, przekształcanie i ładowanie, po wykonaniu tych operacji wyczyszczone dane są przechowywane w innej bazie danych. Przykładem takiej bazy danych byłby HDFS, który jest częścią Hadoop. Hive to hurtownia danych, która będzie działać na systemie plików takich jak ten. Hive jest tym, czego używałbyś do analizy, do generowania raportów i wyciągania spostrzeżeń.

ETL jest bardzo ważnym krokiem w przetwarzaniu danych, aby oczyścić surowe dane i mieć odpowiednią formę do przechowywania w bazie danych. Wyciąg odnosi się do operacji wyciągania nieustrukturyzowanych, niespójnych danych z brakującym polem i wartościami z oryginalnego źródła. Transform oznacza serię operacji, które można zastosować do danych w celu ich wyczyszczenia lub uzyskania.

Wstępne obliczanie przydatnych informacji zbiorczych, przetwarzanie pól w celu dopasowania do określonego formatu, wszystko to jest częścią czyszczenia danych pól transformacji.

Wreszcie Pig wykonuje operację ładowania, w której te czyste dane są przechowywane w bazie danych, gdzie można je dalej analizować. Przykładem standardowej operacji wykonywanej przez Pig jest czyszczenie plików dziennika.

Wyjaśnij architekturę świń

W Architekturze jest wiele części Świni, wolą:

- Parser : Parser zajmuje się skryptami Pig, a także sprawdza składnię skryptu, sprawdza typ i różne inne kontrole. Dodatkowo, ich wynikiem może być DAG (Directed Acyclic Graph), który zwykle oznacza twierdzenia Pig Latin wraz z operatorami logicznymi.

Ponadto operatory logiczne ze skryptem będą wyświetlane podobnie jak węzły, a przepływ danych będzie pokazywany od krawędzi przez DAG.

- Optymalizator: Później plan logiczny (DAG) jest zwykle przekraczany w kierunku logicznego optymalizatora. Wykonuje dodatkowe logiczne optymalizacje, w tym projekcję i promuje niskie

- Kompilator: Kompilator kompiluje również ulepszony plan logiczny w grupie prac MapReduce.

- Silnik wykonania: Ostatecznie wszystkie prace MapReduce zostaną wysłane do Hadoop w posortowanej kolejności. W końcu generuje to wymagane wyniki, chociaż prace MapReduce zostaną przeprowadzone za pomocą Hadoop.

- MapReduce: MapReduce został pierwotnie zaprojektowany w Google jako sposób na przetwarzanie stron internetowych w celu usprawnienia wyszukiwania Google. MapReduce rozprowadza obliczenia na wielu komputerach w klastrze. MapReduce wykorzystuje nieodłączną równoległość przetwarzania danych. Nowoczesne systemy, takie jak czujniki, a nawet aktualizacje statusu Facebooka generują miliony rekordów surowych danych.

Działanie na tym poziomie można przygotować w dwóch etapach:

- Mapa

- Redukować

Ty decydujesz, jaką logikę chcesz wdrożyć w tych fazach, aby przetwarzać dane.

- HDFS (Hadoop Distributed File System): Hadoop pozwala na eksplozję przechowywania danych i analiz w skali na nieograniczoną pojemność. Programiści używają aplikacji takich jak Pig, Hive, HBase i Spark do pobierania danych z HDFS.

cechy

Apache Pig ma różne funkcje:

- Prostota programowania: Pig Latin jest porównywalny z SQL, dlatego programiści mogą łatwo utworzyć skrypt Pig. Jeśli znasz język SQL, nauka świni łacińskiej jest niezwykle prosta, ponieważ jest on podobny do języka SQL.

- Bogaty zestaw operatorów: Pig zawiera różnorodny bogaty zestaw operatorów umożliwiający wykonywanie procedur takich jak łączenie, filtrowanie, sortowanie i wiele więcej.

- Możliwości optymalizacji: Wydajność zadania w Apache Pig może być natychmiast zwiększona przez samo zadanie; dlatego programiści muszą skoncentrować się na semantyce tego języka.

- Rozszerzalność: Korzystając z dostępnych operatorów, użytkownicy mogą po prostu rozwijać swoje funkcje do odczytu, przetwarzania i zapisu danych.

- Funkcje zdefiniowane przez użytkownika (UDF): Korzystając z usługi świadczonej przez Pig przy tworzeniu UDF, możemy tworzyć funkcje zdefiniowane przez użytkownika w wielu językach programowania, w tym w Javie, a także wywoływać je lub osadzać w skryptach Pig.

Do czego przydaje się Świnia?

Jest on wykorzystywany zarówno do badania, jak i wykonywania obowiązków, w tym do obsługi doraźnej. Apache Pig może być stosowany do:

Analiza z ogromnymi zbiorami surowych danych preferuje przetwarzanie danych w celu uzyskania stron wyszukiwania. Google, takie jak Yahoo, korzysta z Apache Pig do oceny danych gromadzonych za pośrednictwem Google, a także wyszukiwarek Yahoo. Obsługa dużych zbiorów danych, takich jak rekordy internetowe, przesyłanie strumieniowe informacji online i tak dalej. Nawet aktualizacje statusu Facebooka generują miliony rekordów surowych danych.

W jaki sposób ta technologia pomaga ci rozwijać się w karierze?

Wiele organizacji wdraża Apache Pig niezwykle szybko. Oznacza to, że zawody świń i kariery dla świń rosną codziennie. W ostatnich latach nastąpił ogromny postęp w rozwoju Apache Hadoop. Elementy Hadoop, takie jak Hive, Pig, HDFS, HBase, MapReduce i tak dalej.

Chociaż oferty Hadoop pojawiły się w drugiej dekadzie w tym czasie, eksplodowały w uznaniu w ciągu ostatnich trzech do czterech lat. Wiele firm programistycznych stosuje klastry Hadoop niezwykle często. To może być zdecydowanie najlepsza część dużych zbiorów danych. Eksperci od celu mogliby stać się doświadczonymi w tej doskonałej technologii.

Wniosek

Wiedza Apache Pig jest bardzo potrzebna na rynku i może być przedłużana. Po prostu rozumiejąc pojęcia, a także zdobywając doświadczenie z najlepszymi umiejętnościami Apache Pig w Hadoop, eksperci mogą perfekcyjnie zaangażować się w swój zawód Apache Pig.

Polecany artykuł

To był przewodnik po What is Pig? Omówiliśmy tutaj koncepcje, definicję i architekturę z cechami Pig. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Jak zainstalować Apache

- Pytania do wywiadu Apache PIG

- Co to są usługi sieciowe ASP.Net?

- Co to jest technologia Blockchain?