Wprowadzenie do architektury Big Data

Jeśli chodzi o zarządzanie dużymi danymi i wykonywanie złożonych operacji na tych ogromnych danych, pojawia się potrzeba korzystania z narzędzi i technik dużych zbiorów danych. Kiedy mówimy, że używamy narzędzi i technik dużych zbiorów danych, mamy na myśli, że prosimy o korzystanie z różnych programów i procedur, które znajdują się w ekosystemie dużych zbiorów danych i jego sferze. Dla każdego przypadku użycia nie ma ogólnego rozwiązania, dlatego należy je spreparować i wykonać w sposób skuteczny zgodnie z wymaganiami biznesowymi konkretnej firmy. W związku z tym pojawia się potrzeba korzystania z innej architektury dużych zbiorów danych, ponieważ połączenie różnych technologii spowoduje osiągnięcie wynikowego przypadku użycia. Ustanawiając stałą architekturę, można zapewnić realne rozwiązanie dla żądanego przypadku użycia.

Co to jest architektura Big Data?

- Architektura ta została zaprojektowana w taki sposób, że obsługuje proces przetwarzania, przetwarzanie danych i analiza danych jest zbyt duża lub złożona, aby obsługiwać tradycyjne systemy zarządzania bazami danych.

- Różne organizacje mają różne progi dla swoich organizacji, niektóre mają kilkaset gigabajtów, podczas gdy dla innych nawet niektóre terabajty nie są wystarczająco dobre dla wartości progowej.

- Z uwagi na to zdarzenie, jeśli spojrzysz na systemy towarowe i magazynowanie towarów, wartości i koszty przechowywania znacznie się zmniejszyły. Istnieje ogromna różnorodność danych, które wymagają różnych sposobów zaspokojenia.

- Niektóre z nich są danymi związanymi z partiami, które przychodzą w określonym czasie, dlatego zadania muszą być planowane w podobny sposób, podczas gdy inne należą do klasy przesyłania strumieniowego, w której należy zbudować potok przesyłania strumieniowego w czasie rzeczywistym, aby uwzględnić wszystkie wymagania Wszystkie te wyzwania rozwiązuje architektura Big Data.

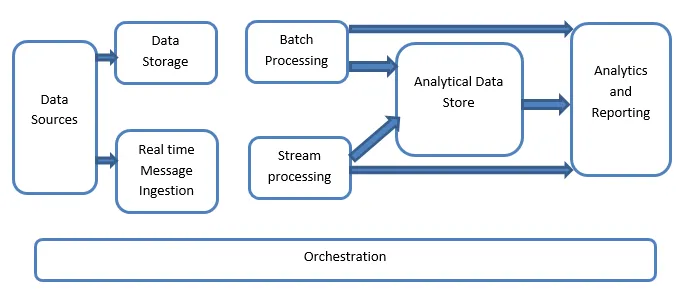

Wyjaśnienie architektury Big Data:

Systemy Big Data obejmują więcej niż jeden typ obciążenia i są ogólnie klasyfikowane w następujący sposób:

- Tam, gdzie źródła oparte na dużych danych są w spoczynku, dotyczy przetwarzania wsadowego.

- Przetwarzanie dużych danych w ruchu do przetwarzania w czasie rzeczywistym.

- Badanie interaktywnych narzędzi i technologii Big Data.

- Uczenie maszynowe i analiza predykcyjna.

1. Źródła danych

Źródła danych obejmują wszystkie te złote źródła, z których zbudowany jest potok wydobywania danych, i dlatego można powiedzieć, że jest to punkt początkowy potoku dużych zbiorów danych.

Przykłady obejmują:

(i) Magazyny danych aplikacji, takie jak te jak relacyjne bazy danych

(ii) Pliki generowane przez wiele aplikacji, które są głównie częścią statycznych systemów plików, takich jak internetowe pliki serwerów generujące dzienniki.

(iii) urządzenia IoT i inne źródła danych oparte na czasie rzeczywistym.

2. Przechowywanie danych

Obejmuje to dane, które są zarządzane dla operacji wykonywanych wsadowo i są przechowywane w magazynach plików, które są rozproszone w naturze i są w stanie pomieścić duże woluminy dużych plików w różnych formatach. Nazywa się to jeziorem danych. Zasadniczo stanowi to część, w której nasze magazyny Hadoop, takie jak HDFS, Microsoft Azure, AWS, GCP, są dostarczane wraz z kontenerami obiektów blob.

3. Przetwarzanie wsadowe

Wszystkie dane są podzielone na różne kategorie lub fragmenty, co wykorzystuje długotrwałe zadania używane do filtrowania i agregowania, a także przygotowywania danych o stanie przetworzonym do analizy. Zadania te zwykle wykorzystują źródła, przetwarzają je i dostarczają dane wyjściowe przetworzonych plików do nowych plików. Przetwarzanie wsadowe odbywa się na różne sposoby przy użyciu zadań Hive lub zadań opartych na języku U-SQL lub przy użyciu Sqoop lub Pig wraz z niestandardowymi zadaniami reduktora map, które są na ogół napisane w dowolnym języku Java, Scala lub innym język taki jak Python.

4. Połknięcie wiadomości w czasie rzeczywistym

Obejmuje to, w przeciwieństwie do przetwarzania wsadowego, wszystkie te systemy przesyłania strumieniowego w czasie rzeczywistym, które obsługują dane generowane sekwencyjnie i według ustalonego wzorca. Często jest to prosta hurtownia danych lub magazyn odpowiedzialny za wszystkie wiadomości przychodzące, które są upuszczane w folderze koniecznie wykorzystywanym do przetwarzania danych. Istnieje jednak większość rozwiązań, które wymagają magazynu wiadomości opartego na komunikatach, który działa jako bufor komunikatów, a także obsługuje przetwarzanie oparte na skali, zapewnia względnie niezawodne dostarczanie wraz z innymi semantykami kolejkowania wiadomości. Dostępne opcje obejmują takie jak Apache Kafka, Apache Flume, centra zdarzeń z platformy Azure itp.

5. Przetwarzanie strumieniowe

Istnieje niewielka różnica między przyjmowaniem wiadomości w czasie rzeczywistym a przetwarzaniem strumienia. Pierwszy uwzględnia uwzględnione dane, które są najpierw gromadzone, a następnie wykorzystywane jako narzędzie do subskrybowania publikacji. Z drugiej strony przetwarzanie strumienia służy do obsługi wszystkich danych przesyłanych strumieniowo w oknach lub strumieniach, a następnie zapisuje dane w ujściu wyjściowym. Obejmuje to Apache Spark, Apache Flink, Storm itp.

6. Magazyn danych oparty na analizie

Jest to magazyn danych wykorzystywany do celów analitycznych, dlatego już przetworzone dane są następnie sprawdzane i analizowane przy użyciu narzędzi analitycznych, które mogą odpowiadać rozwiązaniom BI. Dane mogą być również prezentowane za pomocą technologii hurtowni danych NoSQL, takiej jak HBase, lub dowolnego interaktywnego wykorzystania bazy danych gałęzi, która może zapewnić abstrakcję metadanych w magazynie danych. Narzędzia obejmują Hive, Spark SQL, Hbase itp.

7. Raportowanie i analiza

Informacje muszą być generowane na temat przetwarzanych danych, co skutecznie wykonują narzędzia do raportowania i analizy, które wykorzystują wbudowaną technologię i rozwiązanie do generowania przydatnych wykresów, analiz i informacji pomocnych dla firm. Narzędzia obejmują Cognos, Hyperion itp.

8. Orkiestracja

Rozwiązania oparte na dużych danych składają się z operacji związanych z danymi, które są z natury powtarzalne i są również zawarte w przepływach pracy, które mogą przekształcać dane źródłowe, a także przenosić dane między źródłami, a także ujścia i obciążenia w sklepach i wypychać do jednostek analitycznych. Przykłady obejmują Sqoop, oozie, fabrykę danych itp.

Wniosek

W tym poście czytamy o architekturze Big Data, która jest niezbędna do wdrożenia tych technologii w firmie lub organizacji. Mam nadzieję, że podoba Ci się nasz artykuł.

Polecane artykuły

To był przewodnik po architekturze Big Data. Tutaj omawiamy, co to jest Big Data? a także wyjaśniliśmy architekturę dużych zbiorów danych wraz ze schematem blokowym. Możesz także przejrzeć nasze inne sugerowane artykuły, aby dowiedzieć się więcej -

- Technologie Big Data

- Analiza dużych zbiorów danych

- Kariera w Big Data

- Pytania do wywiadu Big Data

- 8 najlepszych urządzeń IoT, które powinieneś znać

- Rodzaje złączeń w Spark SQL (przykłady)