Co to jest technologia Big Data?

Jak wiemy, dane stale się zmieniają. Wzrost ilości danych zmusił ludzkie umysły do wydobywania, analizowania i radzenia sobie z tym. Jest tak, ponieważ tradycyjne sposoby postępowania z danymi nie obsługują tych dużych danych. Duże zbiory danych opisują zwykle trzy pojęcia: objętość, różnorodność i prędkość.

Dane stały się teraz najważniejszym zasobem każdej firmy. Analiza tych dużych danych pomaga firmie analizować zachowanie klienta i przewidywać istotne rzeczy związane z tymi decyzjami. Decyzje oparte na danych sprawiają, że organizacja podejmuje bardziej pewne ruchy i buduje silniejsze strategie.

Znając tempo, w jakim rosną dane w dzisiejszej erze, duże zbiory danych będą w niedalekiej przyszłości gigantycznym obszarem do pracy. Wszyscy studenci, odświeżacze, specjaliści będą potrzebni, aby być na bieżąco z nowymi technologiami Big Data. Utrzymywanie aktualności przyniesie wspaniałą i udaną karierę na ścieżce zawodowej.

Technologie Big Data

Oto kilka technologii big data z przejrzystym wyjaśnieniem, abyś był świadomy nadchodzących trendów i technologii:

-

Apache Spark:

Jest to szybki silnik przetwarzania dużych danych. Zostało to zbudowane z uwzględnieniem przetwarzania danych w czasie rzeczywistym. Bogata biblioteka uczenia maszynowego dobrze sprawdza się w przestrzeni AI i ML. Przetwarza dane równolegle i na komputerach klastrowych. Podstawowym typem danych wykorzystywanym przez Spark jest RDD (odporny rozproszony zestaw danych).

-

Bazy danych NoSQL:

To nierelacyjne bazy danych, które zapewniają szybkie przechowywanie i wyszukiwanie danych. Jego zdolność do radzenia sobie z wszelkiego rodzaju danymi, takimi jak dane ustrukturyzowane, częściowo ustrukturyzowane, nieustrukturyzowane i polimorficzne, jest wyjątkowa. Żadna baza danych SQL nie ma następujących typów:

- Bazy danych dokumentów : przechowuje dane w postaci dokumentów, które mogą zawierać wiele różnych par klucz-wartość.

- Przechowuje wykresy : przechowuje dane, które zwykle są przechowywane w postaci sieci, takie jak dane z mediów społecznościowych.

- Magazyny klucz-wartość : są to najprostsze bazy danych NoSQL. Każdy element w bazie danych jest przechowywany jako nazwa atrybutu (lub „klucz”) wraz z jego wartością.

- Sklepy z szerokimi kolumnami : Ta baza danych przechowuje dane w formacie kolumnowym, a nie w formacie wierszowym. Cassandra i HBase są tego dobrymi przykładami.

-

Apache Kafka:

Kafka to platforma do strumieniowego przesyłania wydarzeń, która codziennie obsługuje wiele wydarzeń. Ponieważ jest szybki i skalowalny, jest to pomocne w budowaniu potoków przesyłania strumieniowego danych w czasie rzeczywistym, które niezawodnie pobierają dane między systemami lub aplikacjami.

-

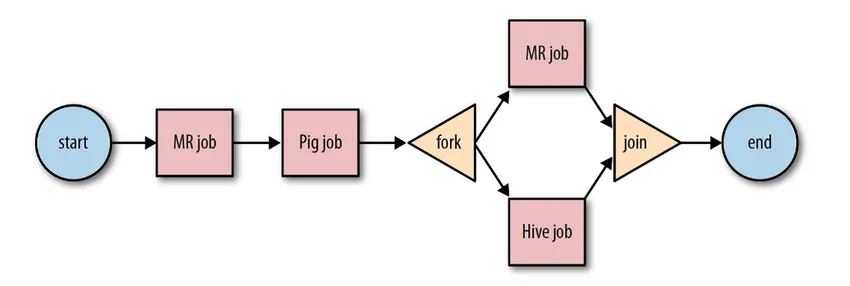

Apache Oozie:

Jest to system planowania przepływu pracy do zarządzania zadaniami Hadoop. Te zadania przepływu pracy są zaplanowane w formie Directed Acyclical Graphs (DAG) dla akcji.

Źródło: Google

To skalowalne i zorganizowane rozwiązanie dla działań w zakresie dużych zbiorów danych.

-

Przepływ powietrza Apache:

Jest to platforma, która planuje i monitoruje przepływ pracy. Inteligentne planowanie pomaga w zorganizowaniu efektywnego zakończenia projektu. Przepływ powietrza ma możliwość ponownego uruchomienia instancji DAG, gdy wystąpi awaria. Bogaty interfejs użytkownika ułatwia wizualizację rurociągów działających na różnych etapach, takich jak produkcja, monitorowanie postępów i rozwiązywanie problemów w razie potrzeby.

-

Wiązka Apache:

Jest to model ujednolicony, służący do definiowania i wykonywania potoków przetwarzania danych, które obejmują ETL i ciągłe przesyłanie strumieniowe. Framework Apache Beam zapewnia abstrakcję między logiką aplikacji a ekosystemem dużych zbiorów danych, ponieważ nie istnieje interfejs API, który wiązałby wszystkie frameworki, takie jak Hadoop, Spark itp.

-

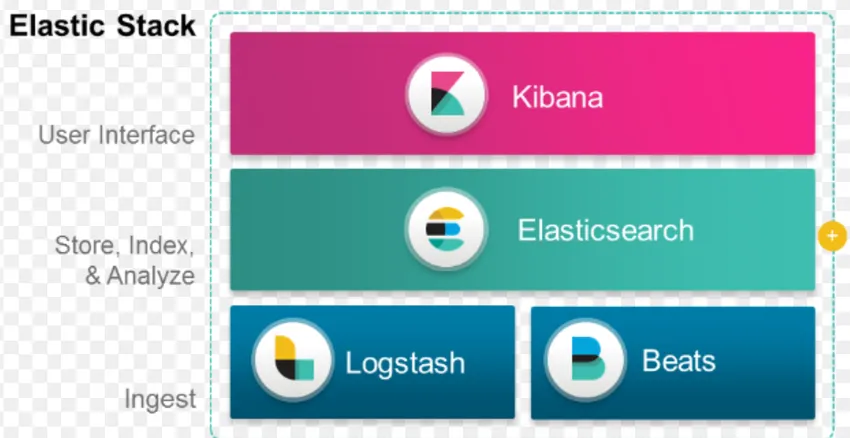

Stos ELK:

ELK jest znany z Elasticsearch, Logstash i Kibana.

Elasticsearch to baza danych bez schematu (która indeksuje każde pojedyncze pole), która ma potężne możliwości wyszukiwania i jest łatwo skalowalna.

Logstash to narzędzie ETL, które pozwala nam pobierać, przekształcać i przechowywać zdarzenia w Elasticsearch.

Kibana to narzędzie do pulpitów nawigacyjnych dla Elasticsearch, w którym możesz analizować wszystkie przechowywane dane. Przydatne informacje uzyskane z Kibana pomagają w budowaniu strategii dla organizacji. Od rejestrowania zmian do prognoz, Kibana zawsze była bardzo przydatna.

-

Docker & Kubernete:

Są to nowe technologie, które pomagają aplikacjom działać w kontenerach Linux. Docker to zbiór narzędzi typu open source, które pomagają „Budować, wysyłać i uruchamiać dowolną aplikację w dowolnym miejscu”.

Kubernetes to także otwarta platforma / platforma do aranżacji, umożliwiająca harmonijną współpracę dużej liczby kontenerów. To ostatecznie zmniejsza obciążenie operacyjne.

-

TensorFlow:

Jest to biblioteka uczenia maszynowego typu open source, która służy do projektowania, budowania i szkolenia modeli dogłębnego uczenia się. Wszystkie obliczenia są wykonywane w TensorFlow za pomocą grafów przepływu danych. Wykresy zawierają węzły i krawędzie. Węzły reprezentują operacje matematyczne, a krawędzie reprezentują dane.

TensorFlow jest pomocny w badaniach i produkcji. Został zbudowany z myślą o tym, że może działać na wielu procesorach lub procesorach graficznych, a nawet na mobilnych systemach operacyjnych. Można to zaimplementować w Pythonie, C ++, R i Javie.

-

Presto:

Presto to silnik SQL typu open source opracowany przez Facebooka, który jest w stanie przetwarzać petabajty danych. W przeciwieństwie do Hive, Presto nie zależy od techniki MapReduce, a tym samym szybszego pobierania danych. Jego architektura i interfejs są wystarczająco łatwe do interakcji z innymi systemami plików.

Ze względu na małe opóźnienia i łatwe interaktywne zapytania, obecnie staje się bardzo popularny do obsługi dużych zbiorów danych.

-

Polybase:

Polybase działa na bazie SQL Server, aby uzyskać dostęp do danych przechowywanych w PDW (Parallel Data Warehouse). PDW zbudowany do przetwarzania dowolnej ilości danych relacyjnych i zapewnia integrację z Hadoop.

-

Ul:

Hive to platforma służąca do wysyłania zapytań i analizy danych w dużych zestawach danych. Zapewnia podobny do SQL język zapytań o nazwie HiveQL, który wewnętrznie jest konwertowany na MapReduce, a następnie przetwarzany.

Wraz z szybkim wzrostem danych i ogromnym dążeniem organizacji do analizy dużych zbiorów danych, technologia wprowadziła na rynek tak wiele dojrzałych technologii, że ich znajomość jest ogromną korzyścią. Obecnie technologia dużych zbiorów danych zaspokaja wiele potrzeb biznesowych i problemów, zwiększając wydajność operacyjną i przewidując odpowiednie zachowanie. Kariera w dziedzinie dużych zbiorów danych i powiązanych z nią technologii może otworzyć wiele możliwości dla osoby, a także dla firm.

Odtąd najwyższy czas na wdrożenie technologii dużych zbiorów danych.

Polecane artykuły

To był przewodnik po technologii Big Data. Omówiliśmy tutaj kilka technologii dużych zbiorów danych, takich jak Hive, Apache Kafka, Apache Beam, ELK Stack itp. Możesz także przeczytać następujący artykuł, aby dowiedzieć się więcej -

- Co to jest głębokie uczenie się?

- Przewodnik po Minitabie?

- Co to jest technologia Salesforce?

- Co to jest analityka Big Data?