Różnica między Hadoop a SQL

Ogromne dane generowane co sekundę za pośrednictwem mediów społecznościowych takich jak Facebook, Twitter, Instagram utorowały drogę do rozwoju ekosystemu Hadoop / Big Data. Termin „3 V” odnoszący się do Objętości, Prędkości i Prawdziwości określa znaczenie Hadoop w obsłudze danych przesyłanych strumieniowo. Obecnie dane są generowane z wielu źródeł, które należy zintegrować do różnych celów, takich jak raportowanie, analiza danych i badania oraz do scentralizowanego przechowywania danych. Kiedy to robimy, pojawiają się liczne problemy z tradycyjnymi podejściami, takie jak przestrzeń, dostęp, integralność, struktura i przepustowość. Aby poradzić sobie z tymi wszystkimi problemami, Hadoop zapewnia platformę umożliwiającą przetwarzanie danych o ogromnych rozmiarach, zapewniającą łatwy dostęp, wysoką dostępność i dynamiczne ładowanie danych. Ma strukturę rozproszonego systemu plików (HDFS) do przechowywania danych i wbudowany procesor zapytań o nazwie „Map Reduce” do analizy i przetwarzania danych przechowywanych w HDFS.

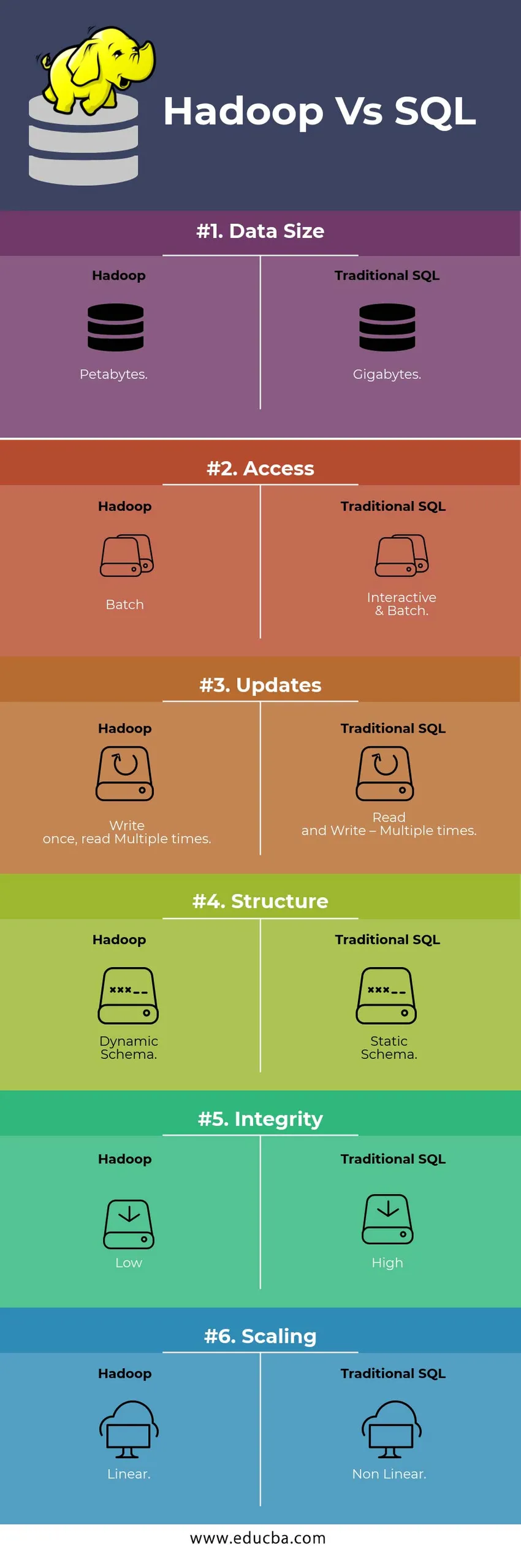

Porównanie HEAD TO HEAD między Hadoop Vs SQL

Poniżej znajduje się 6 najważniejszych różnic między Hadoop Vs SQL

Kluczowe różnice między Hadoop a SQL

Poniżej znajduje się różnica między Hadoop i SQL:

- Schemat na WRITE Vs READ

Zasadniczo w tradycyjnej bazie danych podczas ładowania / migracji danych z jednej bazy danych do innej, zgodnie ze schematem zapisu. To powoduje, że proces ładowania danych zostaje wzbudzony / przerwany i skutkuje odrzuceniem rekordów z powodu różnicy w strukturze tabel źródłowych i docelowych, podczas gdy w systemie Hadoop - wszystkie dane są przechowywane w HDFS, a dane są scentralizowane.

Struktura Hadoop jest używana głównie w procesie analizy danych. W ten sposób obsługuje wszystkie trzy kategorie danych, tj. Dane ustrukturyzowane, częściowo ustrukturyzowane i nieustrukturyzowane, i umożliwia podejście oparte na odczycie.

- Dane strukturalne mają określony format. g .: plik XML.

- Dane Semi Structures są luźniejsze; Może mieć / nie mieć schematu. g .: arkusz kalkulacyjny

- Dane nieustrukturyzowane nie mają określonej struktury ani schematu. Np .: Zwykły tekst lub obraz.

Hadoop działa skutecznie z nieustrukturyzowanymi danymi, ponieważ ma możliwość interpretacji danych w czasie przetwarzania.

| Podejście | Korzyść | Wadą |

| Schemat przy zapisie | · Wstępnie zdefiniowane struktury

· Szybszy odczyt. Np .: tradycyjny RDBMS. | Powolne ładowanie danych

Duże opóźnienie |

| Schemat na odczyt | · Struktura dynamiczna

· Szybkie pisanie i czytanie. Np .: Hadoop | Szybkie ładowanie danych

Małe opóźnienia |

Tabela : Schemat na WRITE VS Schemat na READ.

- SKALOWALNOŚĆ I KOSZT

Hadoop Framework jest zaprojektowany do przetwarzania dużej ilości danych. Za każdym razem, gdy zwiększa się rozmiar danych, do klastra można bardzo łatwo dodać wiele dodatkowych zasobów, takich jak węzeł danych, niż tradycyjne podejście do przydzielania pamięci statycznej. Czas i budżet są stosunkowo bardzo krótsze na ich wdrożenie, a także Hadoop zapewnia lokalizację danych, w której dane są udostępniane w węźle, który wykonał zadanie.

- USTERKA TOLERANCJA

W tradycyjnym RDBMS, gdy dane są tracone z powodu uszkodzenia lub problemów z siecią, odzyskanie utraconych danych zajmuje więcej czasu, kosztów i zasobów. Ale Hadoop ma mechanizm, w którym dane mają co najmniej trzy poziomy współczynnika replikacji dla danych przechowywanych w HDFS. Jeśli jeden z węzłów danych przechowujących dane ulegnie awarii, dane można łatwo wyciągnąć z innych węzłów danych o wysokiej dostępności danych. Dzięki temu dane są łatwo dostępne dla użytkownika, niezależnie od jakiejkolwiek awarii.

- PROGRAMOWANIE FUNKCJONALNE

Hadoop obsługuje pisanie programowania funkcjonalnego w językach takich jak Java, Scala i Python. Dla każdej aplikacji wymagającej dodatkowej funkcjonalności można wdrożyć rejestrując UDF - Funkcje zdefiniowane przez użytkownika w HDFS. W RDBMS nie ma możliwości pisania UDF, co zwiększa złożoność pisania SQL. Ponadto dane przechowywane w HDFS mogą być dostępne dla wszystkich ekosystemów Hadoop, takich jak Hive, Pig, Sqoop i HBase. Tak więc, jeśli zapisany jest UDF, może być używany przez dowolną z wyżej wymienionych aplikacji. Zwiększa wydajność i obsługę systemu.

- OPTYMALIZACJA

Hadoop przechowuje dane w HDFS i przetwarzaj choć Map Reduce z ogromnymi technikami optymalizacji. Najpopularniejszymi technikami używanymi do przetwarzania danych są partycjonowanie i segmentowanie przechowywanych danych. Partycjonowanie to podejście do przechowywania danych w systemie plików HDFS poprzez dzielenie danych na podstawie kolumny wspomnianej do partycjonowania. Gdy dane są wstrzykiwane lub ładowane do HDFS, identyfikuje kolumnę partycji i wypycha dane do odpowiedniego katalogu partycji. Zatem zapytanie pobiera zestaw wyników, bezpośrednio pobierając dane z katalogu podzielonego na partycje. Zmniejsza to skanowanie całego stołu, poprawia czas odpowiedzi i pozwala uniknąć opóźnień.

Inne podejście nazywa się segmentowaniem danych. Umożliwia to analitykowi łatwą dystrybucję danych między węzłami danych. Wszystkie węzły będą miały taką samą liczbę dystrybuowanych danych. Kolumna segmentu jest wybierana w taki sposób, że ma najmniejszą liczność.

Te podejścia nie są dostępne w tradycyjnej metodzie SQL.

- TYP DANYCH

W tradycyjnym podejściu obsługiwane typy danych są bardzo ograniczone. Obsługuje tylko uporządkowane dane. Dlatego czyszczenie i formatowanie samego schematu danych zajmie więcej czasu. Ale Hadoop obsługuje złożone typy danych, takie jak Array, Struct i Map. Zachęca to do korzystania z różnych rodzajów zestawu danych do ładowania danych. Na przykład: dane XML można załadować, definiując dane za pomocą elementów XML zawierających złożony typ danych.

- KOMPRESJA DANYCH

W tradycyjnym systemie baz danych dostępnych jest znacznie mniej wbudowanych technik kompresji. Ale dla frameworka Hadoop istnieje wiele technik kompresji, takich jak gzib, bzip2, LZO i snappy. Domyślny tryb kompresji to LZ4. Nawet tabele można kompresować za pomocą technik kompresji, takich jak Parquet, ORC. Techniki kompresji pomagają sprawić, aby tabele zajmowały bardzo mniej miejsca, zwiększając przepustowość i szybsze wykonywanie zapytań.

Hadoop Vs SQL Tabela porównawcza

| Charakterystyka | Tradycyjny SQL | Hadoop |

| Rozmiar danych | Gigabajty | Petabajty |

| Dostęp | Interactive & Batch | Partia |

| Aktualizacje | Odczyt i zapis - wiele razy | Napisz raz, przeczytaj Wiele razy |

| Struktura | Schemat statyczny | Schemat dynamiczny |

| Integralność | Wysoki | Niska |

| skalowanie | Nieliniowy | Liniowy |

Tabela : Porównanie tradycyjnego Hadoop i SQL Framework.

Wniosek - Hadoop kontra SQL

Ogólnie rzecz biorąc, Hadoop wyprzedza tradycyjny SQL pod względem kosztów, czasu, wydajności, niezawodności, obsługi i dostępności danych dla bardzo dużej grupy użytkowników. Aby efektywnie radzić sobie z ogromną ilością danych generowanych każdego dnia, platforma Hadoop pomaga w terminowym przechwytywaniu, przechowywaniu, przetwarzaniu, filtrowaniu i wreszcie przechowywaniu w nim w scentralizowanym miejscu.

Polecany artykuł

- Hadoop vs Hive - Znajdź najlepsze różnice

- Poznaj 10 przydatnych różnic między Hadoop a Redshift

- HADOOP vs RDBMS | Poznaj 12 przydatnych różnic

- Apache Hadoop vs Apache Spark | 10 najlepszych porównań, które musisz znać!

- Hadoop vs Spark: Funkcje